Ein Entwickler sollte lernen, die Grafikverarbeitungseinheit (GPU) des Geräts effektiv zu nutzen, damit die Anwendung nicht langsamer wird oder unnötige Arbeit ausführt.

Konfigurieren Sie die GPU-Rendering-Einstellungen

Wenn Ihre App träge ist, bedeutet das, dass die Aktualisierung einiger oder aller Aktualisierungsrahmen des Bildschirms länger als 16 Millisekunden dauert. Um Frame-Updates visuell auf dem Bildschirm anzuzeigen, können Sie eine spezielle Option auf dem Gerät aktivieren (Profile GPU Rendering).

Sie können schnell erkennen, wie lange das Rendern von Frames dauert. Ich möchte Sie daran erinnern, dass Sie es innerhalb von 16 Millisekunden halten müssen.

Die Option ist auf Geräten ab Android 4.1 verfügbar. Der Entwicklermodus muss auf dem Gerät aktiviert sein. Auf Geräten mit Version 4.2 und höher ist der Modus standardmäßig ausgeblendet. Zum Aktivieren gehen Sie zu Einstellungen | Über das Telefon und klicken Sie sieben Mal auf die Zeile Build-Nummer.

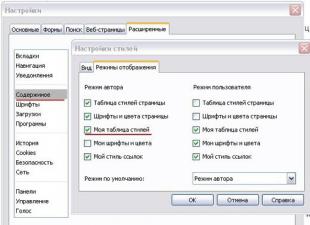

Gehen Sie nach der Aktivierung zu Entwickleroptionen und den Punkt finden Konfigurieren Sie die GPU-Rendering-Einstellungen(Profil-GPU-Rendering), das aktiviert sein sollte. Wählen Sie im Popup-Fenster die Option aus Auf dem Bildschirm in Form von Spalten(Auf dem Bildschirm als Balken). In diesem Fall wird das Diagramm über der laufenden Anwendung angezeigt.

Sie können nicht nur Ihre Anwendung testen, sondern auch andere. Starten Sie eine beliebige Anwendung und beginnen Sie damit zu arbeiten. Während Sie arbeiten, wird am unteren Bildschirmrand eine aktualisierte Grafik angezeigt. Die horizontale Achse stellt die verstrichene Zeit dar. Die vertikale Achse zeigt die Zeit für jeden Frame in Millisekunden. Bei der Interaktion mit der Anwendung werden von links nach rechts vertikale Balken auf dem Bildschirm gezeichnet, die die Frame-Leistung im Zeitverlauf anzeigen. Jede dieser Spalten stellt einen Rahmen zum Zeichnen des Bildschirms dar. Je höher die Spaltenhöhe, desto länger dauert das Zeichnen. Die dünne grüne Linie dient als Orientierung und entspricht 16 Millisekunden pro Frame. Daher müssen Sie beim Studium Ihrer Bewerbung darauf achten, dass die Grafik nicht über diese Linie hinausgeht.

Schauen wir uns eine größere Version des Diagramms an.

Die grüne Linie ist für 16 Millisekunden verantwortlich. Um innerhalb von 60 Bildern pro Sekunde zu bleiben, muss jeder Diagrammbalken unterhalb dieser Linie gezeichnet werden. Irgendwann wird die Säule zu groß und viel höher als die grüne Linie sein. Das bedeutet, dass das Programm langsamer wird. Jede Spalte enthält Cyan, Lila (Lollipop und höher), Rot und Orange.

Die blaue Farbe ist für die Zeit verantwortlich, die zum Erstellen und Aktualisieren benötigt wird Sicht.

Der violette Teil stellt die Zeit dar, die für die Übertragung der Rendering-Ressourcen des Threads aufgewendet wurde.

Die rote Farbe stellt die Zeit zum Zeichnen dar.

Die orange Farbe zeigt an, wie lange die CPU gewartet hat, bis die GPU ihre Arbeit abgeschlossen hat. Dies ist die Ursache für Probleme bei großen Werten.

Um die Belastung der GPU zu reduzieren, gibt es spezielle Techniken.

Debuggen Sie die GPU-Überlastungsanzeige

Mit einer anderen Einstellung erfahren Sie, wie oft derselbe Bereich des Bildschirms neu gezeichnet wird (d. h. zusätzliche Arbeit geleistet wird). Lass uns noch einmal gehen Entwickleroptionen und den Punkt finden Debuggen Sie die GPU-Überlastungsanzeige(Debug GPU Overdraw), das aktiviert sein sollte. Wählen Sie im Popup-Fenster die Option aus Overlay-Zonen anzeigen(Überzeichnungsbereiche anzeigen). Hab keine Angst! Einige Elemente auf dem Bildschirm ändern ihre Farbe.

Gehen Sie zu einer beliebigen Anwendung zurück und beobachten Sie, wie sie funktioniert. Die Farbe weist auf Problembereiche in Ihrer Anwendung hin.

Wenn sich die Farbe in der Anwendung nicht verändert hat, ist alles in Ordnung. Es gibt keine Überlagerung einer Farbe über einer anderen.

Die blaue Farbe zeigt an, dass eine Ebene über der darunter liegenden Ebene gezeichnet wird. Bußgeld.

Grüne Farbe – zweimal neu gezeichnet. Sie müssen über eine Optimierung nachdenken.

Rosa Farbe – dreimal neu gezeichnet. Alles ist sehr schlecht.

Rote Farbe – viele Male neu gezeichnet. Etwas ist schief gelaufen.

Sie können Ihre Bewerbung selbst überprüfen, um Problembereiche zu finden. Erstellen Sie eine Aktivität und platzieren Sie eine Komponente darauf Textansicht. Geben Sie dem Stammelement und der Textbeschriftung einen Hintergrund im Attribut Android:Hintergrund. Sie erhalten Folgendes: Zuerst haben Sie die unterste Aktivitätsebene mit einer Farbe bemalt. Dann wird eine neue Ebene darüber gezeichnet Textansicht. Eigentlich übrigens Textansicht Text wird ebenfalls gezeichnet.

An manchen Stellen sind überlappende Farben nicht zu vermeiden. Aber stellen Sie sich vor, dass Sie den Hintergrund für die Liste auf die gleiche Weise festlegen ListView, das den gesamten Aktivitätsbereich einnimmt. Das System wird eine doppelte Aufgabe erfüllen, obwohl der Benutzer nie die unterste Aktivitätsebene sehen wird. Und wenn Sie zusätzlich für jedes Element der Liste ein eigenes Markup mit eigenem Hintergrund erstellen, werden Sie in der Regel überfordert.

Ein kleiner Rat. Nach Methode platzieren setContentView() Aufrufen einer Methode, die verhindert, dass der Bildschirm mit der Designfarbe bemalt wird. Dies hilft dabei, eine zusätzliche Farbüberlagerung zu entfernen:

GetWindow().setBackgroundDrawable(null);

Verwendung von GPU-Computing mit C++ AMP

Bisher haben wir bei der Erörterung paralleler Programmiertechniken nur Prozessorkerne berücksichtigt. Wir haben einige Fähigkeiten im Parallelisieren von Programmen über mehrere Prozessoren hinweg, im Synchronisieren des Zugriffs auf gemeinsam genutzte Ressourcen und im Verwenden von Hochgeschwindigkeits-Synchronisationsprimitiven ohne den Einsatz von Sperren erworben.

Es gibt jedoch eine andere Möglichkeit, Programme zu parallelisieren – Grafikprozessoren (GPUs), mit mehr Kernen als selbst Hochleistungsprozessoren. GPU-Kerne eignen sich hervorragend für die Implementierung paralleler Datenverarbeitungsalgorithmen, und ihre große Anzahl macht die Unannehmlichkeiten, die mit der Ausführung von Programmen auf ihnen verbunden sind, mehr als wett. In diesem Artikel lernen wir eine der Möglichkeiten kennen, Programme auf einer GPU auszuführen, indem wir eine Reihe von C++-Spracherweiterungen namens „ C++AMP.

Die C++ AMP-Erweiterungen basieren auf der Sprache C++, weshalb in diesem Artikel Beispiele in C++ gezeigt werden. Allerdings bei mäßiger Nutzung des Interaktionsmechanismus in. NET können Sie C++ AMP-Algorithmen in Ihren .NET-Programmen verwenden. Aber darüber werden wir am Ende des Artikels sprechen.

Einführung in C++ AMP

Im Wesentlichen ist eine GPU derselbe Prozessor wie jeder andere, jedoch mit einem speziellen Befehlssatz, einer großen Anzahl von Kernen und einem eigenen Speicherzugriffsprotokoll. Es gibt jedoch große Unterschiede zwischen modernen GPUs und herkömmlichen Prozessoren, und deren Verständnis ist der Schlüssel zum Erstellen von Programmen, die die Rechenleistung effizient nutzen. GPU.

Moderne GPUs verfügen über einen sehr kleinen Befehlssatz. Dies impliziert einige Einschränkungen: fehlende Möglichkeit zum Aufrufen von Funktionen, begrenzte Anzahl unterstützter Datentypen, fehlende Bibliotheksfunktionen und andere. Einige Vorgänge, beispielsweise bedingte Verzweigungen, können erheblich mehr kosten als ähnliche Vorgänge, die auf herkömmlichen Prozessoren ausgeführt werden. Offensichtlich erfordert das Verschieben großer Codemengen von der CPU auf die GPU unter solchen Bedingungen einen erheblichen Aufwand.

Die Anzahl der Kerne ist bei einer durchschnittlichen GPU deutlich höher als bei einem durchschnittlichen herkömmlichen Prozessor. Einige Aufgaben sind jedoch zu klein oder können nicht in ausreichend große Teile zerlegt werden, um von der GPU zu profitieren.

Die Synchronisierungsunterstützung zwischen GPU-Kernen, die dieselbe Aufgabe ausführen, ist sehr schlecht und zwischen GPU-Kernen, die unterschiedliche Aufgaben ausführen, fehlt sie völlig. Dieser Umstand erfordert eine Synchronisierung des Grafikprozessors mit einem herkömmlichen Prozessor.

Es stellt sich sofort die Frage: Welche Aufgaben eignen sich zur Lösung auf einer GPU? Bedenken Sie, dass nicht jeder Algorithmus für die Ausführung auf einer GPU geeignet ist. GPUs haben beispielsweise keinen Zugriff auf E/A-Geräte, sodass Sie die Leistung eines Programms, das RSS-Feeds aus dem Internet scrapt, nicht mithilfe einer GPU verbessern können. Viele Rechenalgorithmen lassen sich jedoch auf die GPU übertragen und massiv parallelisieren. Nachfolgend finden Sie einige Beispiele für solche Algorithmen (diese Liste ist keineswegs vollständig):

zunehmende und abnehmende Bildschärfe und andere Transformationen;

schnelle Fourier-Transformation;

Matrixtransposition und -multiplikation;

Zahlensortierung;

direkte Hash-Inversion.

Eine ausgezeichnete Quelle für zusätzliche Beispiele ist der Microsoft Native Concurrency-Blog, der Codeausschnitte und Erklärungen für verschiedene in C++ AMP implementierte Algorithmen bereitstellt.

C++ AMP ist ein in Visual Studio 2012 enthaltenes Framework, das C++-Entwicklern eine einfache Möglichkeit bietet, Berechnungen auf der GPU durchzuführen, wobei nur ein DirectX 11-Treiber erforderlich ist. Microsoft hat C++ AMP als offene Spezifikation veröffentlicht, die von jedem Compiler-Anbieter implementiert werden kann.

Mit dem C++ AMP-Framework können Sie Code ausführen Grafikbeschleuniger, das sind Computergeräte. Mithilfe des DirectX 11-Treibers erkennt das C++ AMP-Framework alle Beschleuniger dynamisch. C++ AMP umfasst außerdem einen Software-Beschleuniger-Emulator und einen herkömmlichen prozessorbasierten Emulator, WARP, der als Fallback auf Systemen ohne GPU oder mit GPU dient, aber keinen DirectX 11-Treiber hat und mehrere Kerne und SIMD-Anweisungen verwendet.

Beginnen wir nun mit der Erforschung eines Algorithmus, der für die Ausführung auf einer GPU leicht parallelisiert werden kann. Die folgende Implementierung nimmt zwei Vektoren gleicher Länge und berechnet das punktweise Ergebnis. Etwas Einfacheres kann man sich kaum vorstellen:

Void VectorAddExpPointwise(float* first, float* second, float* result, int length) ( for (int i = 0; i< length; ++i) { result[i] = first[i] + exp(second[i]); } }

Um diesen Algorithmus auf einem regulären Prozessor zu parallelisieren, müssen Sie den Iterationsbereich in mehrere Unterbereiche aufteilen und für jeden einen Ausführungsthread ausführen. Wir haben in früheren Artikeln genau dieser Methode der Parallelisierung unseres ersten Suchbeispiels viel Zeit gewidmet Primzahlen– Wir haben gesehen, wie wir dies erreichen können, indem wir Threads manuell erstellen, Jobs an einen Thread-Pool übergeben und Parallel.For und PLINQ zur automatischen Parallelisierung verwenden. Denken Sie auch daran, dass wir bei der Parallelisierung ähnlicher Algorithmen auf einem herkömmlichen Prozessor besonders darauf geachtet haben, das Problem nicht in zu kleine Aufgaben aufzuteilen.

Für die GPU sind diese Warnungen nicht erforderlich. GPUs verfügen über mehrere Kerne, die Threads sehr schnell ausführen, und die Kosten für den Kontextwechsel sind deutlich geringer als bei herkömmlichen Prozessoren. Unten sehen Sie einen Ausschnitt, der versucht, die Funktion zu verwenden parallel_for_each aus dem C++ AMP-Framework:

#enthalten

avResult.synchronize(); )

Lassen Sie uns nun jeden Teil des Codes einzeln untersuchen. Beachten wir sofort, dass die allgemeine Form der Hauptschleife beibehalten wurde, die ursprünglich verwendete for-Schleife jedoch durch einen Aufruf der Funktion parallel_for_each ersetzt wurde. Tatsächlich ist das Prinzip der Umwandlung einer Schleife in einen Funktions- oder Methodenaufruf für uns nicht neu – eine solche Technik wurde bereits zuvor mit den Methoden Parallel.For() und Parallel.ForEach() aus der TPL-Bibliothek demonstriert. Als nächstes werden die Eingabedaten (Parameter erster, zweiter und Ergebnis) mit Instanzen umschlossen array_view

. Die Klasse array_view wird verwendet, um an die GPU (Beschleuniger) übergebene Daten zu verpacken. Sein Vorlagenparameter gibt den Datentyp und seine Dimension an. Um Anweisungen auf einer GPU auszuführen, die auf Daten zugreifen, die ursprünglich auf einer herkömmlichen CPU verarbeitet wurden, muss sich jemand oder etwas darum kümmern, die Daten auf die GPU zu kopieren, da die meisten modernen Grafikkarten separate Geräte mit eigenem Speicher sind. array_view-Instanzen lösen dieses Problem – sie ermöglichen das Kopieren von Daten bei Bedarf und nur dann, wenn es wirklich benötigt wird. Wenn die GPU die Aufgabe abschließt, werden die Daten zurückkopiert. Indem wir array_view mit einem const-Argument instanziieren, stellen wir sicher, dass „first“ und „second“ in den GPU-Speicher kopiert, aber nicht zurückkopiert werden. Ebenso anrufen verwerfen_data()

Wir schließen das Kopieren des Ergebnisses aus dem Speicher eines regulären Prozessors in den Beschleunigerspeicher aus, diese Daten werden jedoch in die entgegengesetzte Richtung kopiert.

Die Funktion parallel_for_each benötigt ein Extent-Objekt, das die Form der zu verarbeitenden Daten angibt, und eine Funktion, die auf jedes Element im Extent-Objekt angewendet werden soll. Im obigen Beispiel haben wir eine Lambda-Funktion verwendet, deren Unterstützung im ISO C++2011 (C++11)-Standard enthalten ist. Das Schlüsselwort „restrict“ (amp) weist den Compiler an, zu prüfen, ob der Funktionskörper auf der GPU ausgeführt werden kann, und deaktiviert die meisten C++-Syntaxen, die nicht in GPU-Anweisungen kompiliert werden können.<1>Lambda-Funktionsparameter, Index

Zum Schluss der Methodenaufruf synchronisieren() Am Ende der VectorAddExpPointwise-Methode wird sichergestellt, dass die von der GPU erzeugten Berechnungsergebnisse aus array_view avResult zurück in das Ergebnisarray kopiert werden.

Damit ist unsere erste Einführung in die Welt von C++ AMP abgeschlossen, und jetzt sind wir bereit für detailliertere Recherchen sowie weitere interessante Beispiele, die die Vorteile der Verwendung von parallelem Computing auf einer GPU demonstrieren. Die Vektoraddition ist kein guter Algorithmus und aufgrund des hohen Aufwands beim Kopieren von Daten nicht der beste Kandidat für die Demonstration der GPU-Nutzung. Im nächsten Unterabschnitt werden zwei weitere interessante Beispiele gezeigt.

Matrixmultiplikation

Das erste „echte“ Beispiel, das wir uns ansehen werden, ist die Matrixmultiplikation. Zur Implementierung verwenden wir einen einfachen kubischen Matrixmultiplikationsalgorithmus und nicht den Strassen-Algorithmus, der eine Ausführungszeit nahe der kubischen ~O(n 2,807) hat. Gegeben zwei Matrizen, eine m x w-Matrix A und eine w x n-Matrix B, multipliziert das folgende Programm sie und gibt das Ergebnis zurück, eine m x n-Matrix C:

Void MatrixMultiply(int* A, int m, int w, int* B, int n, int* C) ( for (int i = 0; i< m; ++i) { for (int j = 0; j < n; ++j) { int sum = 0; for (int k = 0; k < w; ++k) { sum += A * B; } C = sum; } } }

Es gibt mehrere Möglichkeiten, diese Implementierung zu parallelisieren. Wenn Sie diesen Code so parallelisieren möchten, dass er auf einem regulären Prozessor ausgeführt wird, wäre die Parallelisierung der äußeren Schleife die richtige Wahl. Allerdings verfügt die GPU über eine relativ große Anzahl an Kernen, und wenn wir nur die äußere Schleife parallelisieren, können wir nicht genügend Jobs erstellen, um alle Kerne mit Arbeit zu belasten. Daher ist es sinnvoll, die beiden äußeren Schleifen zu parallelisieren und die innere Schleife unberührt zu lassen:

Void MatrixMultiply (int* A, int m, int w, int* B, int n, int* C) ( array_view

Diese Implementierung ähnelt immer noch stark der sequentiellen Implementierung der Matrixmultiplikation und dem oben angegebenen Beispiel für die Vektoraddition, mit Ausnahme des Index, der jetzt zweidimensional ist und in der inneren Schleife mithilfe des Operators zugänglich ist. Wie viel schneller ist diese Version als die sequentielle Alternative, die auf einem normalen Prozessor läuft? Wenn man zwei Matrizen (Ganzzahlen) der Größe 1024 x 1024 multipliziert, benötigt die sequentielle Version auf einer normalen CPU durchschnittlich 7350 Millisekunden, während die GPU-Version – halten Sie sich fest – 50 Millisekunden benötigt, 147-mal schneller!

Partikelbewegungssimulation

Die oben vorgestellten Beispiele zur Lösung von Problemen auf der GPU verfügen über eine sehr einfache Implementierung der internen Schleife. Es ist klar, dass dies nicht immer der Fall sein wird. Der oben verlinkte Blog „Native Concurrency“ zeigt ein Beispiel für die Modellierung von Gravitationswechselwirkungen zwischen Partikeln. Die Simulation umfasst unendlich viele Schritte; Bei jedem Schritt werden für jedes Teilchen neue Werte der Elemente des Beschleunigungsvektors berechnet und anschließend deren neue Koordinaten bestimmt. Hier wird der Partikelvektor parallelisiert – mit einer ausreichend großen Anzahl von Partikeln (von mehreren Tausend und mehr) können Sie eine ausreichend große Anzahl von Aufgaben erstellen, um alle GPU-Kerne mit Arbeit zu belasten.

Grundlage des Algorithmus ist die Implementierung der Bestimmung des Ergebnisses von Wechselwirkungen zwischen zwei Partikeln, wie unten dargestellt, was sich leicht auf die GPU übertragen lässt:

// hier sind float4 Vektoren mit vier Elementen // die die an den Operationen beteiligten Partikel repräsentieren void bodybody_interaction (float4& Beschleunigung, const float4 p1, const float4 p2) strict(amp) ( float4 dist = p2 – p1; // wird hier nicht verwendet float absDist = dist.x*dist.x + dist.y*dist.z; float invDist = 1.0f / sqrt(absDist); float invDistCube = invDist*invDist; PARTICLE_MASS*invDistCube )

Die Ausgangsdaten bei jedem Modellierungsschritt sind ein Array mit den Koordinaten und Geschwindigkeiten der Partikel. Als Ergebnis der Berechnungen wird ein neues Array mit den Koordinaten und Geschwindigkeiten der Partikel erstellt:

Struct-Partikel ( float4 Position, Geschwindigkeit; // Implementierungen von Konstruktor, Kopierkonstruktor und // Operator =, wobei restriktiv(amp) weggelassen wird, um Platz zu sparen ); void simulation_step(array

Mit Hilfe einer entsprechenden grafischen Oberfläche kann die Modellierung sehr interessant sein. Das vollständige Beispiel des C++ AMP-Teams finden Sie im Native Concurrency-Blog. Auf meinem System mit einem Intel Core i7-Prozessor und einer Geforce GT 740M-Grafikkarte läuft die Simulation von 10.000 Partikeln mit ~2,5 fps (Schritten pro Sekunde) bei Verwendung der sequentiellen Version, die auf dem regulären Prozessor ausgeführt wird, und 160 fps, wenn die optimierte Version ausgeführt wird auf der GPU - eine enorme Leistungssteigerung.

Bevor wir diesen Abschnitt abschließen, gibt es noch eine weitere wichtige Funktion des C++ AMP-Frameworks, die die Leistung von Code, der auf der GPU ausgeführt wird, weiter verbessern kann. GPU-Unterstützung programmierbarer Datencache(oft genannt gemeinsames Gedächtnis). Die in diesem Cache gespeicherten Werte werden von allen Ausführungsthreads in einer einzelnen Kachel gemeinsam genutzt. Dank der Speicherkachelung können Programme, die auf dem C++ AMP-Framework basieren, Daten aus dem Grafikkartenspeicher in den gemeinsamen Speicher des Mosaiks lesen und dann von mehreren Ausführungsthreads darauf zugreifen, ohne die Daten erneut aus dem Grafikkartenspeicher abrufen zu müssen. Der Zugriff auf den gemeinsam genutzten Mosaikspeicher ist etwa zehnmal schneller als auf den Grafikkartenspeicher. Mit anderen Worten: Sie haben Gründe, weiterzulesen.

Um eine gekachelte Version der Parallelschleife bereitzustellen, wird die Methode parallel_for_each übergeben Domäne „tiled_extent“., der das mehrdimensionale Extent-Objekt in mehrdimensionale Kacheln unterteilt, und den lambda-Parameter „tiled_index“, der die globale und lokale ID des Threads innerhalb der Kachel angibt. Beispielsweise kann eine 16x16-Matrix in 2x2-Kacheln unterteilt werden (wie im Bild unten gezeigt) und dann an die Funktion parallel_for_each übergeben werden:

Ausmaß<2>Matrix(16,16); kachel_ausdehnung<2,2>TiledMatrix = Matrix.tile<2,2>(); parallel_for_each(tiledMatrix, [=](tiled_index<2,2>idx) strict(amp) ( // ... ));

Jeder der vier Ausführungsthreads, die zum selben Mosaik gehören, kann die im Block gespeicherten Daten gemeinsam nutzen.

Bei der Ausführung von Operationen mit Matrizen im GPU-Kern anstelle des Standardindex<2>, wie in den obigen Beispielen, können Sie verwenden idx.global. Die ordnungsgemäße Verwendung von lokalem Kachelspeicher und lokalen Indizes kann zu erheblichen Leistungssteigerungen führen. Um gekachelten Speicher zu deklarieren, der von allen Ausführungsthreads in einer einzelnen Kachel gemeinsam genutzt wird, können lokale Variablen mit dem Bezeichner „tile_static“ deklariert werden.

In der Praxis wird häufig die Technik verwendet, gemeinsam genutzten Speicher zu deklarieren und seine einzelnen Blöcke in verschiedenen Ausführungsthreads zu initialisieren:

Parallel_for_each(tiledMatrix, [=](tiled_index<2,2>idx) strict(amp) ( // 32 Bytes werden von allen Threads im Block gemeinsam genutzt Tile_static int local; // Weisen Sie dem Element für diesen Ausführungsthread einen Wert zu local = 42; ));

Offensichtlich können die Vorteile der Verwendung von Shared Memory nur dann erzielt werden, wenn der Zugriff auf diesen Speicher synchronisiert ist. Das heißt, Threads dürfen nicht auf den Speicher zugreifen, bis dieser von einem von ihnen initialisiert wurde. Die Synchronisierung von Threads in einem Mosaik erfolgt mithilfe von Objekten Tile_Barrier(erinnert an die Barrier-Klasse aus der TPL-Bibliothek) – Sie können die Ausführung erst nach dem Aufruf der Methode „tile_barrier.Wait()“ fortsetzen, die die Kontrolle erst dann zurückgibt, wenn alle Threads „tile_barrier.Wait“ aufgerufen haben. Zum Beispiel:

Parallel_for_each(tiledMatrix, (tiled_index<2,2>idx) strict(amp) ( // 32 Bytes werden von allen Threads im Block gemeinsam genutzt Tile_static int local; // Weisen Sie dem Element für diesen Ausführungsthread einen Wert zu local = 42; // idx.barrier ist eine Instanz von Tile_barrier idx.barrier.wait(); // Jetzt kann dieser Thread auf das „lokale“ Array zugreifen, // unter Verwendung der Indizes anderer Ausführungsthreads ));

Jetzt ist es an der Zeit, das Gelernte in ein konkretes Beispiel umzusetzen. Kehren wir zur Implementierung der Matrixmultiplikation zurück, die ohne Verwendung einer Kachelspeicherorganisation durchgeführt wird, und fügen wir die beschriebene Optimierung hinzu. Nehmen wir an, dass die Matrixgröße ein Vielfaches von 256 ist. Dadurch können wir mit 16 x 16 Blöcken arbeiten. Die Natur von Matrizen ermöglicht eine blockweise Multiplikation, und wir können diese Funktion nutzen (tatsächlich dividieren). Die Umwandlung von Matrizen in Blöcke ist eine typische Optimierung des Matrixmultiplikationsalgorithmus und sorgt für eine effizientere CPU-Cache-Nutzung.

Das Wesentliche dieser Technik ist Folgendes. Um C i,j (das Element in Zeile i und Spalte j in der Ergebnismatrix) zu finden, müssen Sie das Skalarprodukt zwischen A i,* (i-te Zeile der ersten Matrix) und B *,j (j) berechnen -te Spalte in der zweiten Matrix). Dies entspricht jedoch der Berechnung der Partialskalarprodukte der Zeile und Spalte und der anschließenden Summierung der Ergebnisse. Wir können diese Tatsache nutzen, um den Matrixmultiplikationsalgorithmus in eine Kachelversion umzuwandeln: