GPU Boost 2.0

Gamit ang NVIDIA GeForce GTX 680 graphics card, mayroon kaming mahalagang bagong feature: GPU Boost. At ang bagong NVIDIA GeForce GTX Titan ay nagpapatuloy ng isang hakbang sa pamamagitan ng pagpapalawak ng tampok na ito sa GPU Boost 2.0. Ang unang bersyon ng GPU Boost 1.0 ay nakatuon sa pinakamataas na konsumo ng kuryente na nakamit sa pinaka-hinihingi na mga modernong laro. Kasabay nito, ang temperatura ng GPU ay hindi gumaganap ng isang espesyal na papel, maliban kung marahil ay malapit na ito sa kritikal na threshold. Ang maximum na dalas ng orasan ay natukoy batay sa kamag-anak na boltahe. Ang kawalan ay medyo halata: Hindi mapigilan ng GPU Boost 1.0 ang mga sitwasyon kung saan, kahit na sa mga hindi kritikal na boltahe, ang temperatura ay tumaas nang labis.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

Nasuri na ng GeForce GTX Titan ang dalawang parameter: boltahe at temperatura. Iyon ay, ang kamag-anak na boltahe (Vref) ay tinutukoy na batay sa dalawang parameter na ito. Siyempre, mananatili ang pag-asa sa mga indibidwal na GPU, dahil may pagkakaiba-iba sa paggawa ng chip, kaya ang bawat video card ay magiging iba sa iba. Ngunit itinuturo ng NVIDIA na, sa teknikal, ang pagdaragdag ng temperatura ay pinapayagan para sa isang average na 3-7 porsiyento na mas mataas na Boost overclocking. Ang teknolohiya ng GPU Boost 2.0 ay maaaring theoretically ma-port sa mas lumang mga graphics card, ngunit ito ay malamang na hindi mangyayari.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

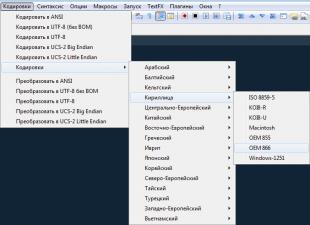

Tingnan natin ang GPU Boost 2.0. Sinusuportahan na ng mga utility tulad ng EVGA Precision Tool o MSI Afterburner ang GPU Boost 2.0. Ginamit namin ang EVGA Precision Tool sa bersyon 4.0.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

Ang GPU Boost 2.0 ay alam ang temperatura, at sa mababang temperatura, ang teknolohiya ay maaaring magpataas ng pagganap nang mas makabuluhang. Ang target na temperatura (Ttarget) ay nakatakda sa 80 °C bilang default.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

Ang teknolohiya ng GPU Boost 2.0 ay naglalaman ng lahat ng mga tampok na pamilyar sa amin mula sa unang henerasyon ng teknolohiya, ngunit sa parehong oras ay ginagawang posible upang magtakda ng isang mas mataas na boltahe, at samakatuwid ay mas mataas na mga frequency ng orasan. Para sa mga overclocker, posibleng baguhin ang mga setting. Maaari mong paganahin ang GPU Overvoltage, ngunit magkaroon ng kamalayan sa potensyal na pagbawas sa buhay ng graphics card.

NVIDIA GeForce GTX Titan - GPU Boost 2.0

NVIDIA GeForce GTX Titan - GPU Boost 2.0

Maaaring itaas ng mga overclocker ang Vref at Vmax (OverVoltaging). Gusto ito ng maraming user sa GK104, ngunit hindi ipinagkatiwala ng NVIDIA ang ganitong pagkakataon sa alinman sa mga user o manufacturer. At ang EVGA GTX 680 Classified video card na sinubukan namin (pagsubok at pagsusuri) ay isang magandang halimbawa lamang. Gamit ang video card na ito, isang espesyal na EVGA Evbot module ang nagbigay sa mga user ng kontrol sa mga boltahe. Ngunit agad na hiniling ng NVIDIA na alisin ng EVGA ang karagdagang hardware mula sa kanilang mga graphics card. Sa kaso ng GPU Boost 2.0 at OverVoltaging, ang NVIDIA mismo ay gumawa ng hakbang sa direksyong ito. Kaya ang mga tagagawa ng graphics card ay maaaring maglabas ng ilang mga modelo ng GeForce GTX Titan, tulad ng mga karaniwang bersyon at factory overclocked na mga bersyon. Ang pag-activate ng OverVoltaging ay ginagawa sa pamamagitan ng switch ng VBIOS (iyon ay, tahasang para sa user upang malaman niya ang mga posibleng kahihinatnan).

| Parameter | Ibig sabihin |

|---|---|

| Pangalan ng chip code | GP104 |

| Produksiyong teknolohiya | 16nm FinFET |

| Bilang ng mga transistor | 7.2 bilyon |

| Core na lugar | 314 mm² |

| Arkitektura | |

| Suporta sa DirectX hardware | |

| Memory bus | |

| 1607 (1733) MHz | |

| Mga bloke sa pag-compute | 20 Streaming Multiprocessors kabilang ang 2560 IEEE 754-2008 floating point scalar ALUs; |

| Texturing block | 160 texture addressing at filtering unit na may suporta para sa FP16 at FP32 na mga bahagi sa mga texture at suporta para sa trilinear at anisotropic na pag-filter para sa lahat ng mga format ng texture |

| Suportahan ang suporta |

| Mga Detalye ng GeForce GTX 1080 Reference Graphics | |

|---|---|

| Parameter | Ibig sabihin |

| Core dalas | 1607 (1733) MHz |

| 2560 | |

| Bilang ng mga bloke ng texture | 160 |

| Bilang ng mga blending block | 64 |

| Epektibong dalas ng memorya | 10000 (4×2500) MHz |

| Uri ng memorya | GDDR5X |

| Memory bus | 256-bit |

| Laki ng memorya | 8 GB |

| 320 GB/s | |

| mga 9 teraflops | |

| 103 gigapixels/s | |

| 257 gigatexels/s | |

| Gulong | PCI Express 3.0 |

| Mga konektor | |

| Pagkonsumo ng enerhiya | hanggang sa 180 W |

| Dagdag na pagkain | Isang 8-pin connector |

| 2 | |

| Inirerekomendang presyo | $599-699 (USA), 54990 RUB (Russia) |

Ang bagong modelo ng GeForce GTX 1080 video card ay nakatanggap ng isang lohikal na pangalan para sa unang solusyon ng bagong serye ng GeForce - ito ay naiiba sa direktang hinalinhan nito lamang sa isang binagong figure ng henerasyon. Ang novelty ay hindi lamang pinapalitan ang mga top-end na solusyon sa kasalukuyang linya ng kumpanya, ngunit naging punong barko din ng bagong serye sa loob ng ilang panahon, hanggang sa mailabas ang Titan X sa mas malalakas na GPU. Sa ibaba nito sa hierarchy ay naroon din ang inihayag na modelong GeForce GTX 1070, batay sa isang stripped-down na bersyon ng GP104 chip, na isasaalang-alang namin sa ibaba.

Ang mga iminungkahing presyo para sa bagong graphics card ng Nvidia ay $599 at $699 para sa regular at Founders Edition (tingnan sa ibaba), ayon sa pagkakabanggit, na isang magandang deal kung isasaalang-alang na ang GTX 1080 ay nauuna hindi lamang sa GTX 980 Ti, kundi pati na rin sa Titan X. Ngayon, ang bagong produkto ay ang pinakamahusay na solusyon sa mga tuntunin ng pagganap sa merkado ng single-chip video card nang walang anumang mga katanungan, at sa parehong oras ito ay mas mura kaysa sa pinakamakapangyarihang mga video card ng nakaraang henerasyon. Sa ngayon, ang GeForce GTX 1080 ay mahalagang walang kakumpitensya mula sa AMD, kaya nagawang magtakda ng Nvidia ng isang presyo na nababagay sa kanila.

Ang video card na pinag-uusapan ay batay sa GP104 chip, na mayroong 256-bit memory bus, ngunit ang bagong uri ng GDDR5X memory ay gumagana sa napakataas na epektibong dalas ng 10 GHz, na nagbibigay ng mataas na peak bandwidth na 320 GB / s - na halos kapareho ng GTX 980 Ti na may 384 -bit na bus. Ang halaga ng memorya na naka-install sa isang video card na may tulad na bus ay maaaring 4 o 8 GB, ngunit magiging hangal na magtakda ng isang mas maliit na halaga para sa isang napakalakas na solusyon sa mga modernong kondisyon, kaya ang GTX 1080 ay nakakuha ng 8 GB ng memorya, at sapat na ang halagang ito para magpatakbo ng anumang mga 3D na application na may anumang mga setting ng kalidad sa loob ng ilang taon na darating.

Ang GeForce GTX 1080 PCB ay maliwanag na naiiba sa mga nakaraang PCB ng kumpanya. Ang halaga ng karaniwang paggamit ng kuryente para sa mga bagong item ay 180 watts - bahagyang mas mataas kaysa sa GTX 980, ngunit kapansin-pansing mas mababa kaysa sa hindi gaanong malakas na Titan X at GTX 980 Ti. Ang reference board ay may karaniwang hanay ng mga connector para sa pagkonekta ng mga image output device: isang Dual-Link DVI, isang HDMI at tatlong DisplayPort.

Disenyo ng sanggunian ng Founders Edition

Kahit na sa anunsyo ng GeForce GTX 1080 noong unang bahagi ng Mayo, isang espesyal na edisyon ng video card na tinatawag na Founders Edition ang inihayag, na may mas mataas na presyo kaysa sa mga regular na video card mula sa mga kasosyo ng kumpanya. Sa katunayan, ang edisyong ito ay ang reference na disenyo ng card at cooling system, at ito ay ginawa mismo ng Nvidia. Maaari kang magkaroon ng iba't ibang mga saloobin sa mga naturang opsyon para sa mga video card, ngunit ang reference na disenyo na binuo ng mga inhinyero ng kumpanya at ginawa gamit ang mga de-kalidad na bahagi ay may mga tagahanga nito.

Ngunit kung magbabayad sila ng ilang libong rubles nang higit pa para sa isang video card mula sa Nvidia mismo ay isang tanong na tanging kasanayan lamang ang makakasagot. Sa anumang kaso, sa una ito ay magiging mga reference na video card mula sa Nvidia na lilitaw sa pagbebenta sa mas mataas na presyo, at walang gaanong mapagpipilian - nangyayari ito sa bawat anunsyo, ngunit ang sanggunian na GeForce GTX 1080 ay naiiba dahil dito ay binalak na ibenta sa form na ito sa buong buhay nito. buhay, hanggang sa paglabas ng mga susunod na henerasyong solusyon.

Naniniwala si Nvidia na ang edisyong ito ay may mga merito kahit na sa mga pinakamahusay na gawa ng mga kasosyo. Halimbawa, ang dalawang-slot na disenyo ng cooler ay nagpapadali sa pag-assemble ng parehong gaming PC na medyo maliit na form factor at multi-chip video system batay sa malakas na video card na ito (kahit na sa kabila ng three- at four-chip operation mode ay hindi inirerekomenda ng kumpanya). Ang GeForce GTX 1080 Founders Edition ay may ilang mga pakinabang sa anyo ng isang mahusay na cooler gamit ang isang evaporative chamber at isang fan na nagtutulak ng pinainit na hangin palabas ng case - ito ang unang solusyon ng Nvidia na kumokonsumo ng mas mababa sa 250 watts ng kapangyarihan.

Kung ikukumpara sa mga nakaraang reference na disenyo ng produkto ng kumpanya, ang power circuit ay na-upgrade mula sa four-phase hanggang five-phase. Pinag-uusapan din ng Nvidia ang tungkol sa mga pinahusay na sangkap kung saan nakabatay ang bagong produkto, ang ingay ng kuryente ay nabawasan din upang mapabuti ang katatagan ng boltahe at potensyal na overclocking. Bilang resulta ng lahat ng mga pagpapabuti, ang power efficiency ng reference board ay tumaas ng 6% kumpara sa GeForce GTX 980.

At upang maiba mula sa "ordinaryong" mga modelo ng GeForce GTX 1080 at sa panlabas, isang hindi pangkaraniwang "tinadtad" na disenyo ng case ang binuo para sa Founders Edition. Na, gayunpaman, marahil ay humantong din sa komplikasyon ng hugis ng evaporation chamber at radiator (tingnan ang larawan), na maaaring isa sa mga dahilan ng pagbabayad ng $100 na dagdag para sa naturang espesyal na edisyon. Inuulit namin na sa simula ng mga benta, ang mga mamimili ay hindi magkakaroon ng maraming pagpipilian, ngunit sa hinaharap posible na pumili ng parehong solusyon na may sariling disenyo mula sa isa sa mga kasosyo ng kumpanya, at gumanap ng Nvidia mismo.

Bagong henerasyon ng Pascal graphics architecture

Ang GeForce GTX 1080 video card ay ang unang solusyon ng kumpanya batay sa GP104 chip, na kabilang sa bagong henerasyon ng Pascal graphics architecture ng Nvidia. Bagama't ang bagong arkitektura ay nakabatay sa mga solusyong ginawa sa Maxwell, mayroon din itong mahahalagang pagkakaiba sa pagganap, na isusulat natin sa ibang pagkakataon. Ang pangunahing pagbabago mula sa isang pandaigdigang pananaw ay ang bago teknolohikal na proseso Ang kung saan ginawa ang bagong GPU.

Ang paggamit ng teknolohiyang proseso ng 16 nm FinFET sa paggawa ng mga GP104 graphics processor sa mga pabrika ng kumpanyang Taiwanese na TSMC ay naging posible upang makabuluhang taasan ang pagiging kumplikado ng chip habang pinapanatili ang isang medyo mababang lugar at gastos. Ihambing ang bilang ng mga transistor at ang lugar ng GP104 at GM204 chips - ang mga ito ay malapit sa lugar (ang chip ng novelty ay pisikal na mas maliit), ngunit ang Pascal architecture chip ay may makabuluhang mas malaking bilang ng mga transistor, at, nang naaayon. , mga execution unit, kabilang ang mga nagbibigay ng bagong functionality.

Mula sa pananaw ng arkitektura, ang unang paglalaro ng Pascal ay halos kapareho sa mga katulad na solusyon ng arkitektura ng Maxwell, bagama't may ilang mga pagkakaiba. Tulad ng Maxwell, ang mga processor ng arkitektura ng Pascal ay magkakaroon ng iba't ibang configuration ng Graphics Processing Clusters (GPCs), Streaming Multiprocessors (SMs), at memory controllers. Ang SM multiprocessor ay isang mataas na parallel multiprocessor na nag-iskedyul at nagpapatakbo ng mga warps (warps, mga grupo ng 32 instruction stream) sa mga CUDA core at iba pang mga execution unit sa multiprocessor. Makakahanap ka ng detalyadong impormasyon tungkol sa disenyo ng lahat ng mga bloke na ito sa aming mga pagsusuri sa mga nakaraang solusyon sa Nvidia.

Ang bawat isa sa SM multiprocessors ay ipinares sa PolyMorph Engine, na humahawak ng texture sampling, tessellation, transformation, vertex attribute setting, at perspective correction. Hindi tulad ng mga nakaraang solusyon ng kumpanya, ang PolyMorph Engine sa GP104 chip ay naglalaman din ng bagong Sabayang Multi-Projection block, na tatalakayin natin sa ibaba. Ang kumbinasyon ng SM multiprocessor na may isang Polymorph Engine ay tradisyonal na tinatawag na TPC - Texture Processor Cluster para sa Nvidia.

Sa kabuuan, ang GP104 chip sa GeForce GTX 1080 ay naglalaman ng apat na GPC cluster at 20 SM multiprocessors, pati na rin ang walong memory controllers na pinagsama sa 64 ROPs. Ang bawat cluster ng GPC ay may nakalaang rasterization engine at may kasamang limang SM. Ang bawat multiprocessor, sa turn, ay binubuo ng 128 CUDA core, 256 KB register file, 96 KB shared memory, 48 KB L1 cache, at walong TMU texture unit. Ibig sabihin, sa kabuuan, ang GP104 ay naglalaman ng 2560 CUDA core at 160 TMU units.

Gayundin, ang graphics processor kung saan nakabatay ang GeForce GTX 1080 ay naglalaman ng walong 32-bit (kumpara sa 64-bit na dating ginamit) memory controllers, na nagbibigay sa amin ng panghuling 256-bit memory bus. Ang walong ROP at 256 KB ng L2 cache ay nakatali sa bawat isa sa mga memory controller. Iyon ay, sa kabuuan, ang GP104 chip ay naglalaman ng 64 ROP at 2048 KB ng L2 cache.

Salamat sa mga pag-optimize sa arkitektura at isang bagong teknolohiya sa proseso, ang unang gaming Pascal ay naging ang pinaka-matipid sa enerhiya na GPU kailanman. Bukod dito, may kontribusyon dito pareho mula sa isa sa mga pinaka-advanced na teknolohikal na proseso 16 nm FinFET, at mula sa mga pag-optimize ng arkitektura na isinagawa sa Pascal, kumpara kay Maxwell. Nagawa ng Nvidia na pataasin ang bilis ng orasan nang higit pa kaysa sa inaasahan nila kapag lumipat sa isang bagong teknolohiya ng proseso. Ang GP104 ay tumatakbo sa mas mataas na frequency kaysa sa hypothetical na GM204 na ginawa gamit ang 16nm na proseso. Upang gawin ito, ang mga inhinyero ng Nvidia ay kailangang maingat na suriin at i-optimize ang lahat ng mga bottleneck ng mga nakaraang solusyon na pumipigil sa overclocking sa itaas ng isang tiyak na threshold. Bilang resulta, ang bagong GeForce GTX 1080 ay tumatakbo sa higit sa 40% na mas mataas na bilis ng orasan kaysa sa GeForce GTX 980. Ngunit hindi lang iyon ang mayroon sa mga pagbabago sa orasan ng GPU.

Teknolohiya ng GPU Boost 3.0

Tulad ng alam na alam natin mula sa mga nakaraang graphics card ng Nvidia, gumagamit sila ng GPU Boost hardware technology sa kanilang mga GPU, na idinisenyo upang pataasin ang operating clock speed ng GPU sa mga mode kung saan hindi pa nito naaabot ang power consumption at mga thermal limit nito. Sa paglipas ng mga taon, ang algorithm na ito ay sumailalim sa maraming mga pagbabago, at ang ikatlong henerasyon ng teknolohiyang ito ay ginagamit na sa Pascal architecture video chip - GPU Boost 3.0, ang pangunahing pagbabago kung saan ay isang mas pinong setting ng mga turbo frequency, depende sa boltahe.

Kung naaalala mo kung paano ito gumagana nakaraang bersyon teknolohiya, ang pagkakaiba sa pagitan ng base frequency (ang garantisadong minimum frequency value sa ibaba kung saan ang GPU ay hindi bumaba, kahit man lang sa mga laro) at ang turbo frequency ay naayos. Iyon ay, ang turbo frequency ay palaging nasa isang tiyak na halaga ng megahertz sa itaas ng base. Ipinakilala ng GPU Boost 3.0 ang kakayahang magtakda ng mga turbo frequency offset para sa bawat boltahe nang hiwalay. Ang pinakamadaling paraan upang maunawaan ito ay sa pamamagitan ng isang ilustrasyon:

Sa kaliwa ay ang GPU Boost ng pangalawang bersyon, sa kanan - ang pangatlo, na lumitaw sa Pascal. Ang nakapirming pagkakaiba sa pagitan ng base at turbo frequency ay hindi nagbigay-daan upang ipakita ang buong kakayahan ng GPU, sa ilang mga kaso, ang mga GPU ng mga nakaraang henerasyon ay maaaring gumana nang mas mabilis sa itakda ang boltahe, ngunit hindi pinahintulutan ng isang nakapirming labis na dalas ng turbo na magawa ito. Sa GPU Boost 3.0, lumitaw ang feature na ito, at maaaring itakda ang turbo frequency para sa bawat isa sa mga indibidwal na halaga ng boltahe, na ganap na pinipiga ang lahat ng juice palabas ng GPU.

Ang mga madaling gamiting utility ay kinakailangan upang pamahalaan ang overclocking at itakda ang turbo frequency curve. Hindi ito ginagawa mismo ng Nvidia, ngunit tinutulungan ang mga kasosyo nito na lumikha ng mga naturang kagamitan upang mapadali ang overclocking (sa loob ng makatwirang mga limitasyon, siyempre). Halimbawa, bago functionality Ang GPU Boost 3.0 ay naihayag na sa EVGA Precision XOC, na may kasamang espesyal na overclocking scanner na awtomatikong hinahanap at itinatakda ang hindi linear na pagkakaiba sa pagitan ng base frequency at turbo frequency sa iba't ibang boltahe sa pamamagitan ng pagpapatakbo ng built-in na performance at stability test. Bilang resulta, nakakakuha ang user ng turbo frequency curve na perpektong tumutugma sa mga kakayahan ng isang partikular na chip. Na, bukod dito, ay maaaring mabago sa anumang paraan manu-manong mode.

Tulad ng makikita mo sa screenshot ng utility, bilang karagdagan sa impormasyon tungkol sa GPU at system, mayroon ding mga setting para sa overclocking: Power Target (tinutukoy ang karaniwang paggamit ng kuryente sa panahon ng overclocking, bilang isang porsyento ng pamantayan), GPU Temp Target (maximum na pinapahintulutang core temperature), GPU Clock Offset (lumampas sa base frequency para sa lahat ng value ng boltahe), Memory Offset (lumampas sa frequency ng memory ng video kaysa sa default na halaga), Overvoltage (karagdagang pagkakataon para mapataas ang boltahe).

Ang Precision XOC utility ay may kasamang tatlong overclocking mode: Basic, Linear, at Manual. Sa pangunahing mode, maaari kang magtakda ng isang solong halaga ng overclock (nakapirming turbo frequency) sa base, tulad ng nangyari sa mga nakaraang GPU. Pinapayagan ka ng linear mode na itakda ang frequency ramp mula sa minimum hanggang sa maximum na mga halaga ng boltahe para sa GPU. Buweno, sa manu-manong mode, maaari kang magtakda ng mga natatanging halaga ng dalas ng GPU para sa bawat punto ng boltahe sa graph.

Kasama rin sa utility ang isang espesyal na scanner para sa awtomatikong overclocking. Maaari mong itakda ang iyong sariling mga antas ng frequency o hayaan ang Precision XOC na i-scan ang GPU sa lahat ng mga boltahe at mahanap ang pinaka-stable na mga frequency para sa bawat punto sa boltahe at frequency curve nang awtomatiko. Sa panahon ng proseso ng pag-scan, unti-unting pinapataas ng Precision XOC ang frequency ng GPU at sinusuri ang operasyon nito para sa katatagan o mga artifact, na bumubuo ng perpektong frequency at boltahe na curve na magiging kakaiba sa bawat partikular na chip.

Maaaring i-customize ang scanner na ito sa sarili mong mga kinakailangan sa pamamagitan ng pagtatakda ng agwat ng oras upang subukan ang bawat halaga ng boltahe, ang minimum at maximum na dalas na susuriin, at ang hakbang nito. Malinaw na upang makamit ang matatag na mga resulta, mas mahusay na magtakda ng isang maliit na hakbang at isang disenteng tagal ng pagsubok. Sa panahon ng pagsubok, maaaring maobserbahan ang hindi matatag na operasyon ng driver ng video at ng system, ngunit kung hindi mag-freeze ang scanner, ibabalik nito ang operasyon at patuloy na mahahanap ang pinakamainam na frequency.

Bagong uri ng video memory GDDR5X at pinahusay na compression

Kaya ang kapangyarihan GPU kapansin-pansing tumaas, at ang memory bus ay nanatiling 256-bit lamang - limitahan ba ng memory bandwidth ang pangkalahatang pagganap at ano ang maaaring gawin tungkol dito? Mukhang masyadong mahal para sa paggawa ang promising second-generation HBM, kaya kinailangan pang maghanap ng ibang mga opsyon. Mula nang ipakilala ang memorya ng GDDR5 noong 2009, tinutuklasan ng mga inhinyero ng Nvidia ang mga posibilidad ng paggamit ng mga bagong uri ng memorya. Bilang resulta, ang mga pag-unlad ay dumating sa pagpapakilala ng isang bagong pamantayan ng memorya na GDDR5X - ang pinakakumplikado at advanced na pamantayan hanggang sa kasalukuyan, na nagbibigay ng rate ng paglipat na 10 Gbps.

Nagbibigay ang Nvidia ng isang kawili-wiling halimbawa kung gaano ito kabilis. 100 picoseconds lang ang lumipas sa pagitan ng mga transmitted bits - sa panahong ito, isang sinag ng liwanag ang maglalakbay sa layo na isang pulgada lang (mga 2.5 cm). At kapag gumagamit ng memorya ng GDDR5X, kailangang piliin ng mga circuit na tumatanggap ng data ang halaga ng ipinadalang bit sa mas mababa sa kalahati ng oras na ito bago ipadala ang susunod - ito ay para lamang maunawaan mo kung ano ang narating ng modernong teknolohiya.

Ang pagkamit ng bilis na ito ay nangangailangan ng pagbuo ng isang bagong arkitektura ng I/O system na nangangailangan ng ilang taon ng pinagsamang pag-unlad sa mga tagagawa ng memory chip. Bilang karagdagan sa tumaas na rate ng paglilipat ng data, tumaas din ang kahusayan ng enerhiya - ang GDDR5X memory chips ay gumagamit ng mas mababang boltahe na 1.35 V at ginawa gamit ang mga bagong teknolohiya, na nagbibigay ng parehong paggamit ng kuryente sa 43% na mas mataas na frequency.

Kinailangan ng mga inhinyero ng kumpanya na muling gawin ang mga linya ng paghahatid ng data sa pagitan ng GPU core at memory chips, na nagbibigay ng higit na pansin sa pagpigil sa pagkawala ng signal at pagkasira ng signal mula sa memorya hanggang sa GPU at pabalik. Kaya, sa paglalarawan sa itaas, ang nakuhang signal ay ipinapakita bilang isang malaking simetriko "mata", na nagpapahiwatig ng mahusay na pag-optimize ng buong circuit at ang kamag-anak na kadalian ng pagkuha ng data mula sa signal. Bukod dito, ang mga pagbabagong inilarawan sa itaas ay humantong hindi lamang sa posibilidad ng paggamit ng GDDR5X sa 10 GHz, ngunit dapat ding makatulong upang makakuha ng mataas na bandwidth ng memorya sa mga hinaharap na produkto gamit ang mas pamilyar na memorya ng GDDR5.

Well, nakakuha kami ng higit sa 40% na pagtaas sa memory bandwidth mula sa paggamit ng bagong memorya. Pero hindi pa ba sapat yun? Upang higit pang mapataas ang kahusayan ng bandwidth ng memorya, ipinagpatuloy ni Nvidia ang pagpapahusay sa advanced na data compression na ipinakilala sa mga nakaraang arkitektura. Gumagamit ang memory subsystem sa GeForce GTX 1080 ng pinahusay at ilang bagong lossless data compression techniques na idinisenyo upang bawasan ang mga kinakailangan sa bandwidth - na ang ikaapat na henerasyon ng on-chip compression.

Ang mga algorithm para sa data compression sa memorya ay nagdadala ng ilang positibong aspeto nang sabay-sabay. Binabawasan ng compression ang dami ng data na nakasulat sa memorya, ang parehong naaangkop sa data na inilipat mula sa memorya ng video patungo sa L2 cache, na nagpapabuti sa kahusayan ng paggamit ng L2 cache, dahil ang isang naka-compress na tile (isang bloke ng ilang framebuffer pixels) ay may mas maliit na sukat kaysa isang hindi naka-compress. Binabawasan din nito ang dami ng data na ipinadala sa pagitan ng iba't ibang punto, tulad ng TMU texture module at framebuffer.

Ang pipeline ng compression ng data sa GPU ay gumagamit ng ilang mga algorithm, na tinutukoy depende sa "compressibility" ng data - ang pinakamahusay na magagamit na algorithm ay pinili para sa kanila. Ang isa sa pinakamahalaga ay ang delta color compression algorithm. Ang paraan ng compression na ito ay nag-encode ng data bilang pagkakaiba sa pagitan ng magkakasunod na mga halaga sa halip na ang data mismo. Kinakalkula ng GPU ang pagkakaiba sa mga halaga ng kulay sa pagitan ng mga pixel sa isang bloke (tile) at iniimbak ang bloke bilang ilang average na kulay para sa buong bloke kasama ang data sa pagkakaiba sa mga halaga para sa bawat pixel. Para sa graphic na data, kadalasang angkop ang pamamaraang ito, dahil ang kulay sa loob ng maliliit na tile para sa lahat ng pixel ay kadalasang hindi masyadong nagkakaiba.

Ang GP104 GPU sa GeForce GTX 1080 ay sumusuporta sa mas maraming compression algorithm kaysa sa nakaraang Maxwell chips. Kaya, ang 2:1 compression algorithm ay naging mas mahusay, at bilang karagdagan dito, dalawang bagong algorithm ang lumitaw: isang 4:1 compression mode, na angkop para sa mga kaso kung saan ang pagkakaiba sa halaga ng kulay ng mga pixel ng isang bloke ay napaka maliit, at isang 8:1 mode, na pinagsasama ang pare-parehong 4:1 compression ng 2×2 pixel block na may 2x delta compression sa pagitan ng mga block. Kapag hindi posible ang compression, hindi ito ginagamit.

Gayunpaman, sa katotohanan, ang huli ay nangyayari nang napakadalas. Ito ay makikita mula sa mga halimbawang screenshot mula sa larong Project CARS, na binanggit ni Nvidia upang ilarawan ang tumaas na compression ratio sa Pascal. Sa mga ilustrasyon, ang mga frame buffer tile na iyon na maaaring i-compress ng GPU ay nilagyan ng kulay ng magenta, at ang mga hindi ma-compress nang walang pagkawala ay nanatili sa orihinal na kulay (itaas - Maxwell, ibaba - Pascal).

Tulad ng nakikita mo, ang mga bagong algorithm ng compression sa GP104 ay talagang mas mahusay kaysa sa Maxwell. Bagama't nagawa rin ng lumang arkitektura na i-compress ang karamihan sa mga tile sa eksena, maraming damo at puno sa paligid ng mga gilid, pati na rin ang mga piyesa ng kotse, ay hindi napapailalim sa mga legacy na compression algorithm. Ngunit sa pagsasama ng mga bagong diskarte sa Pascal, ang isang napakaliit na bilang ng mga lugar ng imahe ay nanatiling hindi naka-compress - ang pinabuting kahusayan ay maliwanag.

Bilang resulta ng mga pagpapabuti sa data compression, ang GeForce GTX 1080 ay nagagawang makabuluhang bawasan ang dami ng data na ipinadala sa bawat frame. Sa bilang, ang pinahusay na compression ay nakakatipid ng karagdagang 20% ng epektibong memory bandwidth. Bilang karagdagan sa higit sa 40% na pagtaas sa memory bandwidth ng GeForce GTX 1080 na may kaugnayan sa GTX 980 mula sa paggamit ng GDDR5X memory, lahat ito ay nagbibigay ng humigit-kumulang 70% na pagtaas sa epektibong memory bandwidth kumpara sa nakaraang henerasyong modelo.

Suporta para sa Async Compute

Karamihan sa mga modernong laro ay gumagamit ng mga kumplikadong kalkulasyon bilang karagdagan sa mga graphics. Halimbawa, ang mga kalkulasyon kapag kinakalkula ang pag-uugali ng mga pisikal na katawan ay maaaring isagawa hindi bago o pagkatapos ng mga graphical na kalkulasyon, ngunit sabay-sabay sa kanila, dahil hindi sila nauugnay sa isa't isa at hindi nakasalalay sa bawat isa sa loob ng parehong frame. Ang isa pang halimbawa ay ang post-processing ng mga na-render na frame at ang pagpoproseso ng audio data, na maaari ding isagawa kasabay ng pag-render.

Ang isa pang malinaw na halimbawa ng functionality na ito ay ang Asynchronous Time Warp technique na ginagamit sa mga VR system upang baguhin ang na-render na frame ayon sa paggalaw ng ulo ng player bago ito i-render, na nakakaabala sa pag-render ng susunod. Ang ganitong asynchronous na pag-load ng mga kapasidad ng GPU ay nagbibigay-daan sa pagtaas ng kahusayan ng paggamit ng mga yunit ng pagpapatupad nito.

Lumilikha ang mga workload na ito ng dalawang bagong senaryo sa paggamit ng GPU. Ang una sa mga ito ay kinabibilangan ng mga overlapping load, dahil maraming uri ng mga gawain ang hindi ganap na gumagamit ng mga kakayahan ng mga GPU, at ang ilang mga mapagkukunan ay walang ginagawa. Sa ganitong mga kaso, maaari ka lang magpatakbo ng dalawang magkaibang gawain sa parehong GPU, na naghihiwalay sa mga unit ng pagpapatupad nito upang makakuha ng mas mahusay na paggamit - halimbawa, mga PhysX effect na tumatakbo kasabay ng 3D rendering ng frame.

Upang mapabuti ang pagganap ng sitwasyong ito, ipinakilala ng arkitektura ng Pascal ang dynamic na pagbabalanse ng pagkarga. Sa nakaraang arkitektura ng Maxwell, ipinatupad ang mga overlapping na workload bilang isang static na pamamahagi ng mga mapagkukunan ng GPU sa pagitan ng mga graphics at compute. Ang diskarte na ito ay epektibo sa kondisyon na ang balanse sa pagitan ng dalawang workload ay halos tumutugma sa paghahati ng mga mapagkukunan at ang mga gawain ay tumatakbo nang pantay sa oras. Kung ang mga hindi graphical na kalkulasyon ay mas matagal kaysa sa mga graphical, at pareho silang naghihintay para sa pagkumpleto ng karaniwang gawain, ang bahagi ng GPU ay magiging idle para sa natitirang oras, na magdudulot ng pagbaba sa pangkalahatang pagganap at magpapawalang-bisa sa lahat ng mga benepisyo. Ang dynamic na load balancing ng hardware, sa kabilang banda, ay nagbibigay-daan sa iyo na gamitin ang nabakanteng mga mapagkukunan ng GPU sa sandaling maging available ang mga ito - para sa pag-unawa, magbibigay kami ng isang paglalarawan.

Mayroon ding mga gawain na kritikal sa oras, at ito ang pangalawang senaryo para sa asynchronous computing. Halimbawa, ang pagpapatupad ng asynchronous time distortion algorithm sa VR ay dapat makumpleto bago ang pag-scan out o ang frame ay itatapon. Sa ganoong kaso, dapat suportahan ng GPU ang napakabilis na pagkagambala sa gawain at lumipat sa isa pang gawain upang makagawa ng hindi gaanong kritikal na gawain mula sa pagpapatupad sa GPU, na nagpapalaya sa mga mapagkukunan nito para sa mga kritikal na gawain - ito ay tinatawag na preemption.

Ang isang solong render command mula sa isang game engine ay maaaring maglaman ng daan-daang mga draw call, ang bawat draw call naman ay naglalaman ng daan-daang mga na-render na triangle, bawat isa ay naglalaman ng daan-daang pixel na kakalkulahin at iguguhit. Ang tradisyonal na diskarte sa GPU ay gumagamit lamang ng mataas na antas ng pagkagambala sa gawain, at ang graphics pipeline ay kailangang maghintay para makumpleto ang lahat ng gawaing iyon bago lumipat ng mga gawain, na nagreresulta sa napakataas na latency.

Upang ayusin ito, unang ipinakilala ng arkitektura ng Pascal ang kakayahang matakpan ang isang gawain sa antas ng pixel - Pixel Level Preemption. Ang mga yunit ng pagpapatupad ng Pascal GPU ay maaaring patuloy na subaybayan ang pag-usad ng mga gawain sa pag-render, at kapag hiniling ang isang interrupt, maaari nilang ihinto ang pagpapatupad, na i-save ang konteksto para sa pagkumpleto sa ibang pagkakataon sa pamamagitan ng mabilis na paglipat sa isa pang gawain.

Ang interrupt sa antas ng thread at toggle para sa mga pagpapatakbo ng pag-compute ay gumagana nang katulad ng pagkagambala sa antas ng pixel para sa graphics computing. Ang mga computational workload ay binubuo ng maraming grids, bawat isa ay naglalaman ng maraming thread. Kapag natanggap ang isang interrupt request, ang mga thread na tumatakbo sa multiprocessor ay wawakasan ang kanilang pagpapatupad. Ang iba pang mga bloke ay nagse-save ng kanilang sariling estado upang magpatuloy mula sa parehong punto sa hinaharap, at ang GPU ay lumipat sa isa pang gawain. Ang buong proseso ng paglipat ng gawain ay tumatagal ng mas mababa sa 100 microseconds pagkatapos lumabas ang tumatakbong mga thread.

Para sa mga workload sa paglalaro, ang kumbinasyon ng mga pixel-level na interrupts para sa mga graphics, at thread-level interrupts para sa mga gawain sa pag-compute ay nagbibigay sa Pascal architecture GPU ng kakayahang mabilis na lumipat sa pagitan ng mga gawain na may kaunting pagkawala ng oras. At para sa mga gawain sa pag-compute sa CUDA, posible ring matakpan nang may kaunting granularity - sa antas ng pagtuturo. Sa mode na ito, ang lahat ng mga thread ay huminto sa pagpapatupad nang sabay-sabay, agad na lumipat sa isa pang gawain. Ang diskarte na ito ay nangangailangan ng pag-save ng higit pang impormasyon tungkol sa estado ng lahat ng mga rehistro ng bawat thread, ngunit sa ilang mga kaso ng hindi graphical na mga kalkulasyon ito ay lubos na makatwiran.

Ang paggamit ng mga mabilis na interrupt at pagpapalit ng gawain sa mga graphical at computational na gawain ay idinagdag sa arkitektura ng Pascal upang ang mga graphical at hindi graphical na gawain ay maantala sa antas ng mga indibidwal na tagubilin, sa halip na buong mga thread, tulad ng nangyari kina Maxwell at Kepler . Ang mga teknolohiyang ito ay maaaring mapabuti ang asynchronous na pagpapatupad ng iba't ibang mga GPU workload at mapabuti ang pagtugon kapag nagpapatakbo ng maraming gawain nang sabay-sabay. Sa kaganapan ng Nvidia, nagpakita sila ng isang pagpapakita ng gawain ng mga asynchronous na kalkulasyon gamit ang halimbawa ng pagkalkula ng mga pisikal na epekto. Kung walang asynchronous na mga kalkulasyon ang pagganap ay nasa antas ng 77-79 FPS, pagkatapos ay sa pagsasama ng mga tampok na ito, ang frame rate ay tumaas sa 93-94 FPS.

Nagbigay na kami ng halimbawa ng isa sa mga posibilidad para sa paggamit ng functionality na ito sa mga laro sa anyo ng asynchronous time distortion sa VR. Ipinapakita ng paglalarawan ang pagpapatakbo ng teknolohiyang ito na may tradisyonal na pagkaantala (preemption) at mabilis. Sa unang kaso, ang proseso ng asynchronous time distortion ay sinubukang isagawa nang huli hangga't maaari, ngunit bago magsimula ang pag-update ng imahe sa display. Ngunit ang gawain ng algorithm ay dapat ibigay sa pagpapatupad sa GPU ng ilang millisecond nang mas maaga, dahil walang mabilis na pagkagambala walang paraan upang tumpak na maisagawa ang trabaho sa tamang oras, at ang GPU ay idle nang ilang oras.

Sa kaso ng tumpak na pagkaantala sa antas ng pixel at thread (ipinapakita sa kanan), ang kakayahang ito ay nagbibigay ng higit na katumpakan sa pagtukoy ng sandali ng pagkaantala, at ang asynchronous time warping ay maaaring magsimula nang may pagtitiwala sa pagkumpleto ng trabaho bago ang magsisimula ang pag-update ng impormasyon sa display. At idle nang ilang oras sa unang kaso, ang GPU ay maaaring i-load ng ilang karagdagang graphic na gawain.

Sabay-sabay na Multi-Projection Technology

Sinusuportahan na ngayon ng bagong GP104 GPU bagong teknolohiya multi-projection (Simultaneous Multi-Projection - SMP), na nagpapahintulot sa GPU na mag-render ng data sa mga modernong imaging system nang mas mahusay. Pinapayagan ng SMP ang video chip na sabay-sabay na magpakita ng data sa ilang projection, na nangangailangan ng pagpapakilala ng bagong hardware block sa GPU bilang bahagi ng PolyMorph engine sa dulo ng geometric pipeline bago ang rasterization block. Ang bloke na ito ay may pananagutan sa pagtatrabaho sa maraming projection para sa isang stream ng geometry.

Ang multi-projection engine ay nagpoproseso ng geometric na data nang sabay-sabay para sa 16 na pre-configure na mga projection na pinagsasama ang projection point (mga camera), ang mga projection na ito ay maaaring malayang paikutin o ikiling. Dahil ang bawat geometry primitive ay maaaring lumabas nang sabay-sabay sa maraming projection, ang SMP engine ay nagbibigay ng functionality na ito, na nagpapahintulot sa application na turuan ang video chip na kopyahin ang geometry nang hanggang 32 beses (16 projection sa dalawang projection center) nang walang karagdagang pagproseso.

Ang buong proseso ng pagproseso ay pinabilis ng hardware, at dahil gumagana ang multiprojection pagkatapos ng geometry engine, hindi nito kailangang ulitin ang lahat ng mga yugto ng pagproseso ng geometry nang maraming beses. Ang mga na-save na mapagkukunan ay mahalaga kapag ang bilis ng pag-render ay nalilimitahan ng pagganap ng pagpoproseso ng geometry, tulad ng tessellation, kapag ang parehong geometric na gawain ay ginanap nang ilang beses para sa bawat projection. Alinsunod dito, sa peak case, maaaring bawasan ng multi-projection ang pangangailangan para sa pagproseso ng geometry nang hanggang 32 beses.

Ngunit bakit kailangan ang lahat ng ito? Mayroong ilang magagandang halimbawa kung saan maaaring maging kapaki-pakinabang ang teknolohiyang multi-projection. Halimbawa, isang multi-monitor system na may tatlong display na naka-mount sa isang anggulo sa isa't isa na malapit sa user (surround configuration). Sa isang karaniwang sitwasyon, ang eksena ay nai-render sa isang projection, na humahantong sa mga geometric distortion at maling geometry na pag-render. Ang tamang paraan ay tatlong magkakaibang projection para sa bawat isa sa mga monitor, ayon sa anggulo kung saan sila matatagpuan.

Gamit ang isang video card sa isang chip na may arkitektura ng Pascal, magagawa ito sa isang geometry pass, na tumutukoy sa tatlong magkakaibang projection, bawat isa para sa ibang monitor. At ang gumagamit, sa gayon, ay magagawang baguhin ang anggulo kung saan matatagpuan ang mga monitor sa isa't isa hindi lamang sa pisikal, kundi pati na rin sa halos - sa pamamagitan ng pag-ikot ng mga projection para sa mga side monitor upang makuha ang tamang pananaw sa 3D na eksena gamit ang isang kapansin-pansing mas malawak na anggulo sa pagtingin (FOV). Totoo, may limitasyon dito - para sa naturang suporta, dapat na mai-render ng application ang eksena na may malawak na FOV at gumamit ng mga espesyal na tawag sa SMP API upang itakda ito. Ibig sabihin, hindi mo ito magagawa sa bawat laro, kailangan mo ng espesyal na suporta.

Sa anumang kaso, tapos na ang mga araw ng isang projection sa isang flat monitor, marami na ngayong multi-monitor configuration at curved display na magagamit din ang teknolohiyang ito. Hindi banggitin ang mga virtual reality system na gumagamit ng mga espesyal na lente sa pagitan ng mga screen at mga mata ng user, na nangangailangan ng mga bagong diskarte para sa pag-project ng 3D na imahe sa isang 2D na imahe. Marami sa mga teknolohiya at diskarteng ito ay nasa maagang pag-unlad pa rin, ang pangunahing bagay ay ang mga mas lumang GPU ay hindi maaaring epektibong gumamit ng higit sa isang planar projection. Nangangailangan sila ng maraming rendering pass, maramihang pagpoproseso ng parehong geometry, at iba pa.

Ang Maxwell chips ay may limitadong suporta sa Multi-Resolution upang makatulong na mapataas ang kahusayan, ngunit higit pa ang magagawa ng SMP ng Pascal. Maaaring i-rotate ni Maxwell ang projection nang 90 degrees para sa cube mapping o iba't ibang projection resolution, ngunit ito ay kapaki-pakinabang lamang sa isang limitadong hanay ng mga application tulad ng VXGI.

Kasama sa iba pang mga posibilidad para sa paggamit ng SMP ang pag-render sa iba't ibang mga resolution at single-pass stereo rendering. Halimbawa, ang pag-render sa iba't ibang mga resolution (Multi-Res Shading) ay maaaring gamitin sa mga laro upang i-optimize ang performance. Kapag inilapat, isang mas mataas na resolution ang ginagamit sa gitna ng frame, at sa periphery ito ay binabawasan upang makakuha ng mas mabilis na bilis ng pag-render.

Ginagamit ang single-pass stereo rendering sa VR, naidagdag na ito sa VRWorks package at ginagamit ang feature na multi-projection para bawasan ang dami ng geometric na gawaing kinakailangan sa VR rendering. Kung gagamitin ang feature na ito, isang beses lang pinoproseso ng GeForce GTX 1080 GPU ang scene geometry, na bumubuo ng dalawang projection para sa bawat mata nang sabay-sabay, na binabawasan ng kalahati ang geometric load sa GPU, at binabawasan din ang mga pagkalugi mula sa driver at OS.

Ang isang mas advanced na diskarte para sa pagpapahusay ng kahusayan ng VR rendering ay Lens Matched Shading, na gumagamit ng maraming projection para gayahin ang mga geometric na distortion na kinakailangan sa VR rendering. Gumagamit ang paraang ito ng multi-projection para mag-render ng 3D na eksena sa isang surface na tinatantya ang lens-adjusted surface kapag na-render para sa output ng VR headset, na iniiwasan ang maraming dagdag na pixel sa periphery na itatapon. Ang pinakamadaling paraan upang maunawaan ang kakanyahan ng pamamaraan ay sa pamamagitan ng paglalarawan - apat na bahagyang pinalawak na mga projection ang ginagamit sa harap ng bawat mata (sa Pascal, maaari kang gumamit ng 16 na projection para sa bawat mata - upang mas tumpak na gayahin ang isang curved lens) sa halip na isa:

Ang pamamaraang ito ay maaaring humantong sa makabuluhang pagtitipid sa pagganap. Halimbawa, ang karaniwang Oculus Rift na imahe sa bawat mata ay 1.1 megapixel. Ngunit dahil sa pagkakaiba sa mga projection, upang mai-render ito, ang orihinal na imahe ay 2.1 megapixels - 86% higit pa kaysa sa kinakailangan! Ang paggamit ng multi-projection, na ipinatupad sa arkitektura ng Pascal, ay nagbibigay-daan sa pagbawas ng resolution ng na-render na imahe sa 1.4 megapixels, pagkuha ng 1.5-fold na pag-save sa bilis ng pagproseso ng pixel, at nakakatipid din ng memory bandwidth.

At kasama ng dalawang beses na pagtitipid sa bilis ng pagproseso ng geometry dahil sa single-pass stereo rendering, ang GeForce GTX 1080 graphics processor ay nakakapagbigay ng makabuluhang pagtaas sa pagganap ng pag-render ng VR, na lubhang hinihingi sa bilis ng pagproseso ng geometry, at higit pa sa iba pa. pagpoproseso ng pixel.

Mga pagpapabuti sa output ng video at mga bloke ng pagproseso

Bilang karagdagan sa pagganap at bagong pag-andar na nauugnay sa pag-render ng 3D, kinakailangan upang mapanatili ang isang mahusay na antas ng output ng imahe, pati na rin ang pag-decode at pag-encode ng video. At ang unang Pascal architecture graphics processor ay hindi nabigo - sinusuportahan nito ang lahat ng mga modernong pamantayan sa ganitong kahulugan, kabilang ang hardware decoding ng HEVC format, na kinakailangan para sa panonood ng 4K na mga video sa isang PC. Gayundin, malapit nang ma-enjoy ng mga hinaharap na may-ari ng GeForce GTX 1080 graphics card ang streaming 4K na video mula sa Netflix at iba pang provider sa kanilang mga system.

Sa mga tuntunin ng display output, ang GeForce GTX 1080 ay may suporta para sa HDMI 2.0b na may HDCP 2.2 pati na rin ang DisplayPort. Sa ngayon, na-certify na ang bersyon ng DP 1.2, ngunit handa na ang GPU para sa sertipikasyon para sa mga mas bagong bersyon ng pamantayan: DP 1.3 Ready at DP 1.4 Ready. Ang huli ay nagbibigay-daan sa 4K screen na maipakita sa 120Hz, at 5K at 8K na display sa 60Hz gamit ang isang pares ng DisplayPort 1.3 cable. Kung para sa GTX 980 ang maximum na suportadong resolution ay 5120x3200 sa 60Hz, kung gayon para sa bagong GTX 1080 na modelo ay lumaki ito sa 7680x4320 sa parehong 60Hz. Ang reference na GeForce GTX 1080 ay may tatlong DisplayPort output, isang HDMI 2.0b at isang digital Dual-Link DVI.

Nakatanggap din ang bagong modelo ng Nvidia video card ng pinahusay na block para sa pag-decode at pag-encode ng data ng video. Kaya, ang GP104 chip ay sumusunod sa matataas na pamantayan ng PlayReady 3.0 (SL3000) para sa streaming video playback, na nagbibigay-daan sa iyong makatiyak na ang paglalaro ng mataas na kalidad na nilalaman mula sa mga kilalang provider tulad ng Netflix ay magiging may pinakamataas na kalidad at mahusay sa enerhiya. . Ang mga detalye tungkol sa suporta ng iba't ibang mga format ng video sa panahon ng pag-encode at pag-decode ay ibinibigay sa talahanayan, ang bagong produkto ay malinaw na naiiba mula sa mga nakaraang solusyon para sa mas mahusay:

Ngunit ang isang mas kawili-wiling bagong bagay ay ang suporta para sa tinatawag na High Dynamic Range (HDR) na mga display, na malapit nang maging laganap sa merkado. Ang mga TV ay ibinebenta noong unang bahagi ng 2016 (na may apat na milyong HDR TV na inaasahang ibebenta sa loob lamang ng isang taon), at sinusubaybayan sa susunod na taon. Ang HDR ay ang pinakamalaking tagumpay sa teknolohiya ng display sa mga taon, na naghahatid ng dobleng mga tono ng kulay (75% na nakikitang spectrum kumpara sa 33% para sa RGB), mas maliwanag na mga display (1000 nits) na may mas mataas na contrast (10000:1) at mayayamang kulay.

Ang paglitaw ng kakayahang maglaro ng nilalaman na may mas malaking pagkakaiba sa liwanag at mas mayaman at mas puspos na mga kulay ay magdadala sa imahe sa screen na mas malapit sa katotohanan, ang itim na kulay ay magiging mas malalim, ang maliwanag na liwanag ay masisilaw, tulad ng sa totoong mundo. . Alinsunod dito, ang mga user ay makakakita ng mas maraming detalye sa maliwanag at madilim na lugar ng mga larawan kumpara sa mga karaniwang monitor at TV.

Upang suportahan ang mga HDR display, nasa GeForce GTX 1080 ang lahat ng kailangan mo - 12-bit color output, suporta para sa BT.2020 at SMPTE 2084 na mga pamantayan, at HDMI 2.0b 10/12-bit 4K HDR output. resolution, na ang kaso sa Maxwell. Bilang karagdagan, ang Pascal ay nagdagdag ng suporta para sa pag-decode ng HEVC na format sa 4K na resolusyon sa 60 Hz at 10- o 12-bit na kulay, na ginagamit para sa HDR video, pati na rin ang pag-encode ng parehong format na may parehong mga parameter, ngunit sa 10 lamang -bit para sa HDR video recording o streaming. Gayundin, ang bagong bagay ay handa na para sa DisplayPort 1.4 standardization para sa HDR data transmission sa pamamagitan ng connector na ito.

Oo nga pala, maaaring kailanganin ang HDR video encoding sa hinaharap upang mailipat ang naturang data mula sa isang home PC patungo sa isang SHIELD game console na maaaring maglaro ng 10-bit na HEVC. Ibig sabihin, magagawa ng user na i-broadcast ang laro mula sa isang PC sa HDR na format. Teka, saan ako makakakuha ng mga laro na may ganoong suporta? Patuloy na nakikipagtulungan ang Nvidia sa mga developer ng laro para ipatupad ang suportang ito, ipinapasa sa kanila ang lahat ng kailangan nila (suporta sa driver, mga sample ng code, atbp.) upang mai-render nang tama ang mga HDR na larawan na tugma sa mga kasalukuyang display.

Sa oras ng paglabas ng video card, ang GeForce GTX 1080, mga laro tulad ng Obduction, The Witness, Lawbreakers, Rise of the Tomb Raider, Paragon, The Talos Principle at Shadow Warrior 2 ay may suporta para sa HDR output. Ngunit ang listahang ito ay inaasahang mapupunan sa malapit na hinaharap.

Mga pagbabago sa multi-chip SLI rendering

Mayroon ding ilang mga pagbabago na nauugnay sa pagmamay-ari na teknolohiya ng pag-render ng multi-chip ng SLI, bagama't walang inaasahan ito. Ang SLI ay ginagamit ng mga mahilig sa paglalaro ng PC upang itulak ang pagganap sa alinman sa sukdulan sa pamamagitan ng pagpapatakbo ng pinakamakapangyarihang single-chip graphics card nang magkasabay, o upang makakuha ng napakataas na frame rate sa pamamagitan ng paglilimita sa kanilang sarili sa ilang mga mid-range na solusyon na kung minsan ay mas mura kaysa isang top-end (kontrobersyal na desisyon, ngunit ginagawa nila ito). Sa mga 4K na monitor, ang mga manlalaro ay halos walang ibang mga opsyon kaysa sa pag-install ng ilang video card, dahil kahit na ang mga nangungunang modelo ay madalas na hindi makapagbibigay ng komportableng laro sa maximum na mga setting sa mga ganitong kondisyon.

Isa sa mga mahalagang sangkap Nvidia SLI ay mga tulay na nagkokonekta sa mga video card sa isang karaniwang subsystem ng video at nagsisilbing ayos digital channel para sa paglilipat ng data sa pagitan nila. Tradisyonal na nagtatampok ang mga GeForce graphics card ng dalawahang SLI connector, na nagsilbi upang kumonekta sa pagitan ng dalawa o apat na graphics card sa 3-Way at 4-Way na mga configuration ng SLI. Ang bawat isa sa mga video card ay kailangang konektado sa bawat isa, dahil ang lahat ng mga GPU ay nagpadala ng mga frame na kanilang na-render sa pangunahing GPU, kaya naman kailangan ng dalawang interface sa bawat isa sa mga board.

Simula sa GeForce GTX 1080, lahat ng Nvidia graphics card batay sa arkitektura ng Pascal ay may dalawang interface ng SLI na naka-link nang magkasama upang mapataas ang pagganap ng paglilipat ng data sa pagitan ng mga graphics card, at ang bagong dual-channel na SLI mode na ito ay nagpapabuti sa pagganap at ginhawa kapag nagpapakita ng visual na impormasyon sa napakataas na resolution ng mga display o multi-monitor system.

Para sa mode na ito, kailangan din ng mga bagong tulay, na tinatawag na SLI HB. Pinagsasama nila ang isang pares ng GeForce GTX 1080 video card sa pamamagitan ng dalawang SLI channel nang sabay-sabay, bagama't ang mga bagong video card ay tugma din sa mas lumang mga tulay. Para sa mga resolution na 1920×1080 at 2560×1440 pixels sa refresh rate na 60 Hz, maaaring gamitin ang mga standard na tulay, ngunit sa mga mas demanding mode (4K, 5K at multi-monitor system), ang mga bagong tulay lang ang magbibigay ng mas magandang resulta sa mga tuntunin. ng makinis na pagbabago ng frame, kahit na ang mga luma ay gagana, ngunit medyo mas masahol pa.

Gayundin, kapag gumagamit ng mga SLI HB bridge, ang interface ng data ng GeForce GTX 1080 ay tumatakbo sa 650 MHz, kumpara sa 400 MHz para sa mga kumbensyonal na SLI bridge sa mga mas lumang GPU. Bukod dito, para sa ilan sa mga mahihirap na lumang tulay, ang isang mas mataas na rate ng paglilipat ng data ay magagamit din sa mga video chip ng arkitektura ng Pascal. Sa pagtaas ng rate ng paglipat ng data sa pagitan ng GPU sa pamamagitan ng dobleng interface ng SLI na may mas mataas na dalas ng operasyon, nagbibigay din ng mas maayos na pagpapakita ng mga frame sa screen, kumpara sa mga nakaraang solusyon:

Dapat ding tandaan na ang suporta para sa multi-chip rendering sa DirectX 12 ay medyo naiiba sa kung ano ang nakaugalian noon. AT pinakabagong bersyon graphics API, ang Microsoft ay gumawa ng maraming pagbabago na may kaugnayan sa pagpapatakbo ng naturang mga video system. Mayroong dalawang multi-GPU na opsyon na available sa mga developer ng software sa DX12: Multi Display Adapter (MDA) at Linked Display Adapter (LDA) na mga mode.

Bukod dito, ang LDA mode ay may dalawang anyo: Implicit LDA (na ginagamit ng Nvidia para sa SLI) at Explicit LDA (kapag ang developer ng laro ay nagsasagawa ng gawain ng pamamahala ng multi-chip rendering. Ang MDA at Explicit LDA mode ay ipinatupad lamang sa DirectX 12 noong upang bigyan ang mga developer ng laro ng higit na kalayaan at pagkakataon kapag gumagamit ng mga multi-chip na video system. Ang pagkakaiba sa pagitan ng mga mode ay malinaw na nakikita sa sumusunod na talahanayan:

Sa LDA mode, ang memorya ng bawat GPU ay maaaring konektado sa memorya ng isa pa at ipakita bilang isang malaking kabuuang volume, siyempre, kasama ang lahat ng mga limitasyon sa pagganap kapag ang data ay kinuha mula sa "banyagang" memorya. Sa MDA mode, hiwalay na gumagana ang memorya ng bawat GPU, at hindi direktang ma-access ng iba't ibang GPU ang data mula sa memorya ng isa pang GPU. Ang LDA mode ay idinisenyo para sa mga multi-chip system na may katulad na performance, habang ang MDA mode ay hindi gaanong mahigpit at maaaring gumana kasama ng mga discrete at integrated GPU o discrete solution na may mga chips mula sa iba't ibang manufacturer. Ngunit ang mode na ito ay nangangailangan din ng higit na atensyon at trabaho mula sa mga developer kapag nagtutulungan ang programming upang ang mga GPU ay maaaring makipag-usap sa isa't isa.

Bilang default, ang isang GeForce GTX 1080-based na SLI system ay sumusuporta lamang sa dalawang GPU, at ang tatlo at apat na GPU na configuration ay opisyal na hindi na ginagamit, dahil ang mga modernong laro ay nagiging mas mahirap na makamit ang mga nadagdag sa performance mula sa pagdaragdag ng pangatlo at ikaapat na GPU. Halimbawa, maraming laro ang umaasa sa mga kakayahan ng central processor ng system kapag nagpapatakbo ng mga multi-chip na video system, at ang mga bagong laro ay lalong gumagamit ng temporal (temporal) na mga diskarte na gumagamit ng data mula sa mga nakaraang frame, kung saan ang mahusay na operasyon ng ilang GPU nang sabay-sabay ay imposible lang.

Gayunpaman, nananatiling posible ang pagpapatakbo ng mga system sa iba pang (non-SLI) multi-chip system, gaya ng MDA o LDA Explicit mode sa DirectX 12 o isang two-chip na SLI system na may nakalaang ikatlong GPU para sa PhysX physical effects. Ngunit ano ang tungkol sa mga talaan sa mga benchmark, ang Nvidia ba ay talagang iniiwan ang mga ito nang buo? Hindi, siyempre hindi, ngunit dahil ang mga ganitong sistema ay hinihiling sa mundo ng halos ilang mga gumagamit, isang espesyal na Enthusiast Key ang naimbento para sa mga ultra-enthusiast, na maaaring ma-download mula sa website ng Nvidia at i-unlock ang tampok na ito. Upang gawin ito, kailangan mo munang makakuha ng natatanging GPU ID sa pamamagitan ng pagpapatakbo ng isang espesyal na application, pagkatapos ay hilingin ang Enthusiast Key sa website at, pagkatapos i-download ito, i-install ang key sa system, at sa gayon ay ma-unlock ang 3-Way at 4-Way Mga pagsasaayos ng SLI.

Fast Sync na teknolohiya

Ang ilang mga pagbabago ay naganap sa mga teknolohiya ng pag-synchronize kapag nagpapakita ng impormasyon sa display. Sa hinaharap, walang bago sa G-Sync, at hindi rin sinusuportahan ang teknolohiya ng Adaptive Sync. Ngunit nagpasya ang Nvidia na pagbutihin ang kinis ng output at pag-synchronize para sa mga laro na nagpapakita ng napaka mataas na pagganap kapag ang frame rate ay kapansin-pansing lumampas sa refresh rate ng monitor. Ito ay lalong mahalaga para sa mga laro na nangangailangan ng kaunting latency at mabilis na pagtugon, at kung saan ay mga multiplayer na laban at kumpetisyon.

Ang Fast Sync ay isang bagong alternatibo sa vertical sync na walang visual artifact tulad ng pagpunit sa larawan at hindi nakatali sa isang nakapirming refresh rate, na nagpapataas ng latency. Ano ang problema sa vertical sync sa mga laro tulad ng Counter-Strike: Global Offensive? Ang larong ito sa mga makapangyarihang modernong GPU ay tumatakbo sa ilang daang mga frame bawat segundo, at ang player ay may pagpipilian kung paganahin ang v-sync o hindi.

Sa mga multiplayer na laro, ang mga user ay kadalasang humahabol para sa kaunting mga pagkaantala at i-off ang VSync, na nagiging malinaw na nakikitang pagpunit sa larawan, na lubhang hindi kasiya-siya kahit na sa mataas na frame rate. Gayunpaman, kung i-on mo ang v-sync, makakaranas ang player ng makabuluhang pagtaas sa mga pagkaantala sa pagitan ng kanyang mga aksyon at ng larawan sa screen, kapag bumagal ang pipeline ng graphics sa refresh rate ng monitor.

Ito ay kung paano gumagana ang isang tradisyunal na pipeline. Ngunit nagpasya si Nvidia na paghiwalayin ang proseso ng pag-render at pagpapakita ng imahe sa screen gamit ang teknolohiyang Fast Sync. Ito ay nagpapahintulot sa iyo na magpatuloy hangga't maaari mahusay na trabaho para sa bahagi ng GPU na nag-render ng mga frame sa buong bilis, na nag-iimbak ng mga frame na ito sa isang espesyal na pansamantalang Huling Na-render na Buffer.

Binibigyang-daan ka ng pamamaraang ito na baguhin ang paraan ng pagpapakita at kunin ang pinakamahusay mula sa mga mode ng VSync On at VSync Off, na nakakakuha ng mababang latency, ngunit walang mga artifact ng imahe. Sa Fast Sync, walang frame flow control, tumatakbo ang game engine sa sync-off mode at hindi sinasabing maghintay para iguhit ang susunod, kaya ang mga latency ay halos kasing baba ng VSync Off mode. Ngunit dahil ang Fast Sync ay nakapag-iisa na pumipili ng buffer para sa pagpapakita sa screen at ipinapakita ang buong frame, wala ring mga picture break.

Gumagamit ang Fast Sync ng tatlong magkakaibang buffer, ang unang dalawa ay gumagana katulad ng double buffering sa isang klasikong pipeline. Ang pangunahing buffer (Front Buffer - FB) ay isang buffer, impormasyon kung saan ipinapakita sa display, isang ganap na nai-render na frame. Ang back buffer (Back Buffer - BB) ay ang buffer na tumatanggap ng impormasyon kapag nagre-render.

Kapag gumagamit ng patayong pag-sync sa mga kundisyon ng mataas na frame rate, maghihintay ang laro hanggang sa maabot ang agwat ng pag-refresh upang ipagpalit ang pangunahing buffer sa pangalawang buffer upang ipakita ang larawan ng isang frame sa screen. Pinapabagal nito ang proseso, at pagdaragdag ng mga karagdagang buffer, tulad ng sa tradisyonal Tripleng pag-buffer magdadagdag lamang ng pagkaantala.

Sa Mabilis na Pag-sync, idinagdag ang pangatlong Last Rendered Buffer (LRB), na ginagamit upang iimbak ang lahat ng mga frame na na-render sa pangalawang buffer. Ang pangalan ng buffer ay nagsasalita para sa sarili nito, naglalaman ito ng isang kopya ng huling ganap na nai-render na frame. At kapag dumating ang oras upang i-update ang pangunahing buffer, ang LRB buffer na ito ay kinokopya sa pangunahin sa kabuuan nito, at hindi sa mga bahagi, tulad ng mula sa pangalawang may hindi pinaganang vertical synchronization. Dahil ang pagkopya ng impormasyon mula sa mga buffer ay hindi epektibo, ang mga ito ay pinapalitan lamang (o pinalitan ng pangalan, dahil ito ay magiging mas maginhawang maunawaan), at ang bagong lohika ng pagpapalit ng mga buffer, na ipinakilala sa GP104, ay namamahala sa prosesong ito.

Sa pagsasagawa, ang pagsasama ng isang bagong paraan ng pag-synchronise na Fast Sync ay nagbibigay pa rin ng bahagyang mas malaking pagkaantala kumpara sa ganap na hindi pinaganang vertical synchronization - sa average na 8 ms higit pa, ngunit ito ay nagpapakita ng mga frame sa monitor sa kabuuan nito, nang walang mga hindi kasiya-siyang artifact sa screen na napunit. ang imahe. Maaaring paganahin ang bagong paraan mula sa mga setting ng graphics ng Nvidia control panel sa vertical sync control section. Gayunpaman, ang default na halaga ay nananatiling kontrol ng application, at hindi mo kailangang paganahin ang Fast Sync sa lahat ng 3D application, mas mahusay na piliin ang paraang ito partikular para sa mga laro na may mataas na FPS.

Virtual reality technology Nvidia VRWorks

Nabanggit namin ang mainit na paksa ng VR nang higit sa isang beses sa artikulong ito, ngunit kadalasan ay tungkol sa pagpapalakas ng mga framerate at pagtiyak ng mababang latency, na napakahalaga para sa VR. Napakahalaga ng lahat ng ito at talagang may pag-unlad, ngunit sa ngayon ang mga larong VR ay mukhang hindi gaanong kahanga-hanga kaysa sa pinakamahusay sa mga "regular" na modernong 3D na laro. Nangyayari ito hindi lamang dahil ang mga nangungunang developer ng laro ay hindi pa partikular na kasangkot sa mga VR application, ngunit dahil din sa VR ay mas hinihingi sa frame rate, na pumipigil sa paggamit ng marami sa karaniwang mga diskarte sa mga naturang laro dahil sa mataas na pangangailangan.

Upang mabawasan ang pagkakaiba sa kalidad sa pagitan ng mga laro ng VR at mga regular na laro, nagpasya si Nvidia na maglabas ng isang buong pakete ng mga nauugnay na teknolohiya ng VRWorks, na kinabibilangan ng malaking bilang ng mga API, aklatan, makina at teknolohiya na maaaring makabuluhang mapabuti ang kalidad at pagganap ng VR- mga application. Paano ito nauugnay sa anunsyo ng unang solusyon sa paglalaro sa Pascal? Ito ay napaka-simple - ang ilang mga teknolohiya ay ipinakilala dito na tumutulong sa pagtaas ng produktibidad at pagpapabuti ng kalidad, at naisulat na namin ang tungkol sa mga ito.

At bagama't hindi lamang ito ang mga graphic, pag-uusapan muna natin ito nang kaunti. Kasama sa hanay ng mga teknolohiya ng VRWorks Graphics ang mga naunang nabanggit na teknolohiya, gaya ng Lens Matched Shading, na gumagamit ng feature na multi-projection na lumabas sa GeForce GTX 1080. Ang bagong produkto ay nagbibigay-daan sa iyo na makakuha ng pagtaas ng performance ng 1.5-2 beses na nauugnay sa sa mga solusyon na walang ganoong suporta. Binanggit din namin ang iba pang mga teknolohiya, tulad ng MultiRes Shading, na idinisenyo upang mag-render sa iba't ibang mga resolusyon sa gitna ng frame at sa paligid nito.

Ngunit higit na hindi inaasahan ang pag-anunsyo ng teknolohiya ng VRWorks Audio, na idinisenyo para sa mataas na kalidad na pagkalkula ng sound data sa mga 3D na eksena, na lalong mahalaga sa mga virtual reality system. Sa mga maginoo na makina, ang pagpoposisyon ng mga mapagkukunan ng tunog sa isang virtual na kapaligiran ay kinakalkula nang tama, kung ang kaaway ay bumaril mula sa kanan, kung gayon ang tunog ay mas malakas mula sa bahaging ito ng audio system, at ang gayong pagkalkula ay hindi masyadong hinihingi sa kapangyarihan ng pag-compute. .

Ngunit sa katotohanan, ang mga tunog ay napupunta hindi lamang patungo sa player, ngunit sa lahat ng direksyon at tumalbog sa iba't ibang mga materyales, katulad ng kung paano nag-bounce ang mga light ray. At sa katotohanan, naririnig natin ang mga pagmumuni-muni na ito, kahit na hindi kasinglinaw ng mga direktang alon ng tunog. Ang mga hindi direktang pagmuni-muni ng tunog na ito ay karaniwang ginagaya ng mga espesyal na epekto ng reverb, ngunit ito ay isang napaka-primitive na diskarte sa gawain.

Gumagamit ang VRWorks Audio ng sound wave rendering na katulad ng ray tracing sa pag-render, kung saan ang landas ng mga light ray ay sinusubaybayan sa maraming reflection mula sa mga bagay sa isang virtual na eksena. Ginagaya din ng VRWorks Audio ang pagpapalaganap ng mga sound wave sa kapaligiran kapag sinusubaybayan ang mga direkta at sinasalamin na alon, depende sa anggulo ng saklaw ng mga ito at sa mga katangian ng mga reflective na materyales. Sa trabaho nito, ginagamit ng VRWorks Audio ang high-performance na Nvidia OptiX ray tracing engine na kilala para sa mga gawain sa graphics. Maaaring gamitin ang OptiX para sa iba't ibang gawain, tulad ng pagkalkula ng hindi direktang pag-iilaw at lightmapping, at ngayon din para sa pagsubaybay sa sound wave sa VRWorks Audio.

Gumawa ang Nvidia ng tumpak na pagkalkula ng sound wave sa VR Funhouse demo nito, na gumagamit ng ilang libong ray at nagkalkula ng hanggang 12 reflection mula sa mga bagay. At upang matutunan ang mga pakinabang ng teknolohiya gamit ang isang malinaw na halimbawa, iminumungkahi naming manood ka ng isang video tungkol sa pagpapatakbo ng teknolohiya sa Russian:

Mahalaga na ang diskarte ng Nvidia ay naiiba sa mga tradisyunal na sound engine, kabilang ang pamamaraang pinabilis ng hardware mula sa pangunahing kakumpitensya gamit ang isang espesyal na bloke sa GPU. Ang lahat ng mga pamamaraang ito ay nagbibigay lamang ng tumpak na pagpoposisyon ng mga pinagmumulan ng tunog, ngunit hindi kinakalkula ang mga reflection ng sound wave mula sa mga bagay sa isang 3D na eksena, bagama't maaari nilang gayahin ito gamit ang reverb effect. Gayunpaman, ang paggamit ng teknolohiya ng pagsubaybay sa ray ay maaaring maging mas makatotohanan, dahil ang gayong diskarte lamang ang magbibigay ng tumpak na imitasyon ng iba't ibang mga tunog, na isinasaalang-alang ang laki, hugis at materyales ng mga bagay sa eksena. Mahirap sabihin kung ang naturang computational accuracy ay kinakailangan para sa isang tipikal na player, ngunit masasabi nating sigurado: sa VR, maaari nitong idagdag sa mga user ang napaka-realismo na kulang pa rin sa mga conventional na laro.

Kaya, nananatili para sa amin na sabihin lamang ang tungkol sa teknolohiya ng VR SLI, na gumagana sa parehong OpenGL at DirectX. Napakasimple ng prinsipyo nito: gagana ang isang two-GPU video system sa isang VR application sa paraang ang bawat mata ay inilalaan ng hiwalay na GPU, kumpara sa AFR rendering na pamilyar sa mga configuration ng SLI. Ito ay lubos na nagpapabuti sa pangkalahatang pagganap, na napakahalaga para sa mga virtual reality system. Sa teorya, mas maraming GPU ang maaaring gamitin, ngunit dapat na pantay ang kanilang bilang.

Ang diskarte na ito ay kinakailangan dahil ang AFR ay hindi angkop para sa VR, dahil sa tulong nito ang unang GPU ay gumuhit ng pantay na frame para sa parehong mga mata, at ang pangalawa ay magre-render ng kakaiba, na hindi nakakabawas sa mga pagkaantala na kritikal para sa virtual. sistema ng katotohanan. Kahit na ang frame rate ay magiging medyo mataas. Kaya sa tulong ng VR SLI, ang trabaho sa bawat frame ay nahahati sa dalawang GPU - ang isa ay gumagana sa bahagi ng frame para sa kaliwang mata, ang pangalawa para sa kanan, at pagkatapos ang mga kalahating ito ng frame ay pinagsama sa kabuuan.

Ang paghahati ng ganitong gawain sa pagitan ng isang pares ng mga GPU ay nagdudulot ng 2x na pagtaas sa performance, na nagreresulta sa mas mataas na frame rate at mas mababang latency kumpara sa mga system na nakabatay sa isang graphics card. Totoo, ang paggamit ng VR SLI ay nangangailangan ng espesyal na suporta mula sa application upang magamit ang paraan ng pag-scale na ito. Ngunit ang teknolohiya ng VR SLI ay naka-built na sa mga VR demo app tulad ng Valve's The Lab at ILMxLAB's Trials on Tatooine, at ito ay simula pa lamang - Nangako si Nvidia na darating ang iba pang mga application, pati na rin ang pagpapatupad ng teknolohiya sa mga game engine na Unreal Engine 4 , Unity at Max Play.

Screenshot Platform ng Ansel Game

Ang isa sa mga pinaka-kagiliw-giliw na anunsyo na may kaugnayan sa software ay ang paglabas ng isang teknolohiya para sa pagkuha ng mga de-kalidad na screenshot sa mga application ng paglalaro, na pinangalanan sa isang sikat na photographer - Ansel. Ang mga laro ay matagal nang naging hindi lamang mga laro, kundi isang lugar din para magamit ang mga mapaglarong kamay para sa iba't ibang malikhaing personalidad. May nagpalit ng script para sa mga laro, may naglalabas ng mga de-kalidad na texture set para sa mga laro, at may gumagawa ng magagandang screenshot.

Nagpasya si Nvidia na tulungan ang huli sa pamamagitan ng pagtatanghal bagong platform upang lumikha (ibig sabihin, lumikha, dahil hindi ito isang madaling proseso) mataas na kalidad na mga kuha mula sa mga laro. Naniniwala sila na makakatulong si Ansel na lumikha ng bagong uri ng kontemporaryong sining. Pagkatapos ng lahat, mayroon nang ilang mga artista na gumugol ng halos lahat ng kanilang buhay sa PC, na lumilikha ng magagandang mga screenshot mula sa mga laro, at wala pa rin silang maginhawang tool para dito.

Binibigyang-daan ka ni Ansel na hindi lamang kumuha ng larawan sa laro, ngunit baguhin ito ayon sa kailangan ng lumikha. Gamit ang teknolohiyang ito, maaari mong ilipat ang camera sa paligid ng eksena, paikutin at ikiling ito sa anumang direksyon upang makuha ang nais na komposisyon ng frame. Halimbawa, sa mga laro tulad ng mga first-person shooter, maaari mo lamang ilipat ang player, hindi mo na talaga mababago ang anumang bagay, kaya ang lahat ng mga screenshot ay medyo monotonous. Gamit ang isang libreng camera sa Ansel, maaari kang pumunta nang higit pa camera ng laro, pagpili ng anggulo na kailangan para sa isang magandang larawan, o kahit na kumuha ng ganap na 360-degree na stereo na imahe mula sa kinakailangang punto, at sa mataas na resolution para sa pagtingin sa ibang pagkakataon sa isang VR helmet.

Si Ansel ay gumagana nang simple - sa tulong ng isang espesyal na library mula sa Nvidia, ang platform na ito ay naka-embed sa code ng laro. Para magawa ito, kailangan lang ng developer nito na magdagdag ng maliit na piraso ng code sa kanyang proyekto para payagan ang Nvidia video driver na harangin ang buffer at shader data. Napakakaunting gawaing dapat gawin, ang pagdadala kay Ansel sa laro ay tumatagal ng wala pang isang araw upang maipatupad. Kaya, ang pagsasama ng feature na ito sa The Witness ay tumagal ng humigit-kumulang 40 linya ng code, at sa The Witcher 3 - humigit-kumulang 150 linya ng code.

Darating si Ansel na may kasamang open development package - SDK. Ang pangunahing bagay ay ang gumagamit ay natatanggap kasama niya ang isang karaniwang hanay ng mga setting na nagpapahintulot sa kanya na baguhin ang posisyon at anggulo ng camera, magdagdag ng mga epekto, atbp. Ang platform ng Ansel ay gumagana tulad nito: i-pause nito ang laro, i-on ang libreng camera at nagbibigay-daan sa iyong baguhin ang frame sa nais na view sa pamamagitan ng pagtatala ng resulta sa anyo ng isang regular na screenshot, isang 360-degree na imahe, isang pares ng stereo, o isang panorama lamang ng mataas na resolution.

Ang tanging babala ay hindi lahat ng laro ay makakatanggap ng suporta para sa lahat ng mga tampok ng platform ng screenshot ng laro ng Ansel. Ang ilan sa mga developer ng laro, para sa isang kadahilanan o iba pa, ay hindi nais na magsama ng isang ganap na libreng camera sa kanilang mga laro - halimbawa, dahil sa posibilidad ng mga manloloko na gumagamit ng pagpapaandar na ito. O gusto nilang limitahan ang pagbabago sa anggulo ng pagtingin sa parehong dahilan - upang walang sinuman ang makakuha ng hindi patas na kalamangan. Well, o upang ang mga gumagamit ay hindi makakita ng mga kaawa-awang sprite sa background. Ang lahat ng ito ay medyo normal na mga hangarin ng mga tagalikha ng laro.

Ang isa sa mga pinaka-kagiliw-giliw na tampok ng Ansel ay ang paglikha ng mga screenshot ng simpleng malaking resolusyon. Hindi mahalaga na ang laro ay sumusuporta sa mga resolusyon hanggang sa 4K, halimbawa, at ang monitor ng user ay Full HD. Gamit ang platform ng screenshot, maaari kang kumuha ng mas mataas na kalidad ng imahe, na limitado sa pamamagitan ng laki at pagganap ng drive. Ang platform ay kumukuha ng mga screenshot hanggang sa 4.5 gigapixel nang madali, pinagsama-sama mula sa 3600 piraso!

Malinaw na sa gayong mga larawan maaari mong makita ang lahat ng mga detalye, hanggang sa teksto sa mga pahayagan na nakahiga sa malayo, kung ang gayong antas ng detalye ay nasa prinsipyong ibinigay para sa laro - Makokontrol din ni Ansel ang antas ng detalye, pagtatakda ng pinakamataas na antas upang makuha ang pinakamahusay na kalidad ng larawan. Ngunit maaari mo pa ring paganahin ang supersampling. Ang lahat ng ito ay nagpapahintulot sa iyo na lumikha ng mga larawan mula sa mga laro na maaari mong ligtas na mai-print sa malalaking banner at maging mahinahon tungkol sa kanilang kalidad.

Kapansin-pansin, ang isang espesyal na hardware-accelerated code batay sa CUDA ay ginagamit upang magtahi ng malalaking larawan. Pagkatapos ng lahat, walang video card ang maaaring mag-render ng isang multi-gigapixel na imahe sa kabuuan, ngunit maaari itong gawin sa mga piraso, na kailangan mo lamang pagsamahin sa ibang pagkakataon, isinasaalang-alang ang posibleng pagkakaiba sa pag-iilaw, kulay, at iba pa.

Pagkatapos i-stitching ang gayong mga panorama, isang espesyal na post-processing ang ginagamit para sa buong frame, na pinabilis din sa GPU. At para kumuha ng mga larawan sa mas mataas na dynamic range, maaari kang gumamit ng espesyal na format ng imahe - EXR, isang bukas na pamantayan mula sa Industrial Light and Magic, ang mga value ng kulay sa bawat channel na kung saan ay naitala sa 16-bit na floating point na format. (FP16).

Binibigyang-daan ka ng format na ito na baguhin ang liwanag at dynamic na hanay mga larawan sa pamamagitan ng post-processing, dinadala ito sa kanan para sa bawat partikular na display sa parehong paraan tulad ng ginagawa sa mga RAW na format mula sa mga camera. At para sa kasunod na paggamit ng mga post-processing filter sa mga programa sa pagpoproseso ng imahe, ang format na ito ay lubhang kapaki-pakinabang, dahil naglalaman ito ng mas maraming data kaysa sa karaniwang mga format ng imahe.

Ngunit ang Ansel platform mismo ay naglalaman ng maraming mga post-processing na mga filter, na kung saan ay lalong mahalaga dahil ito ay may access hindi lamang sa panghuling larawan, kundi pati na rin sa lahat ng mga buffer na ginagamit ng laro kapag nagre-render, na maaaring magamit para sa napaka-kagiliw-giliw na mga epekto. , parang depth of field. Para magawa ito, may espesyal na post-processing API si Ansel, at maaaring isama ang alinman sa mga epekto sa laro na may suporta para sa platform na ito.

Kabilang sa mga post-filter ng Ansel ang: color curves, color space, transformation, desaturation, brightness/contrast, film grain, bloom, lens flare, anamorphic glare, distortion, heathaze, fisheye, color aberration, tone mapping, lens dumi, lightshafts , vignette, gamma correction, convolution, sharpening, edge detection, blur, sepia, denoise, FXAA at iba pa.

Tulad ng para sa hitsura ng suporta ng Ansel sa mga laro, kailangan nating maghintay ng kaunti hanggang sa ipatupad at subukan ito ng mga developer. Ngunit ipinangako ng Nvidia na ang gayong suporta ay malapit nang lumitaw sa mga kilalang laro tulad ng The Division, The Witness, Lawbreakers, The Witcher 3, Paragon, Fortnite, Obduction, No Man's Sky, Unreal Tournament at iba pa.

Ang bagong 16nm FinFET process technology at architecture optimizations ay nagbigay-daan sa GeForce GTX 1080 batay sa GP104 GPU na makamit ang mataas na clock speed na 1.6-1.7 GHz kahit na sa reference form, at ginagarantiyahan ng bagong henerasyon ang operasyon sa pinakamataas na posibleng frequency sa mga laro. Mga teknolohiya ng GPU Boost. Kasama ng tumaas na bilang ng mga execution unit, ginagawa ng mga pagpapahusay na ito hindi lamang ang pinakamataas na gumaganap na single-chip graphics card sa lahat ng panahon, kundi pati na rin ang pinaka-epektibong solusyon sa enerhiya sa merkado.

Ang GeForce GTX 1080 ay ang unang graphics card na nagtatampok ng bagong GDDR5X graphics memory, isang bagong henerasyon ng mga high-speed chip na nakakamit ng napakataas na rate ng data. Sa kaso ng isang binagong GeForce GTX 1080, ang ganitong uri ng memorya ay gumagana sa epektibong frequency na 10 GHz. Kasama ng pinahusay na framebuffer compression algorithm, nagresulta ito ng 1.7x na pagtaas sa epektibong memory bandwidth para sa GPU na ito kumpara sa direktang hinalinhan nito, ang GeForce GTX 980.

Maingat na nagpasya si Nvidia na huwag maglabas ng isang radikal na bagong arkitektura sa isang ganap na bagong teknolohiya ng proseso para sa sarili nito, upang hindi makatagpo ng mga hindi kinakailangang problema sa panahon ng pag-unlad at produksyon. Sa halip, seryoso nilang pinagbuti ang dati nang mahusay at napakahusay na arkitektura ng Maxwell sa pamamagitan ng pagdaragdag ng ilang mga tampok. Bilang resulta, maayos ang lahat sa paggawa ng mga bagong GPU, at sa kaso ng modelong GeForce GTX 1080, nakamit ng mga inhinyero ang napakataas na potensyal na dalas - sa mga overclocked na bersyon mula sa mga kasosyo, ang dalas ng GPU ay inaasahang hanggang 2 GHz! Ang ganitong kahanga-hangang dalas ay naging isang katotohanan salamat sa perpektong teknikal na proseso at maingat na gawain ng mga inhinyero ng Nvidia sa pagbuo ng Pascal GPU.

Bagama't si Pascal ay isang direktang tagasunod ng negosyo ng Maxwell, at ang mga graphic na arkitektura na ito sa panimula ay hindi masyadong naiiba sa isa't isa, ipinakilala ng Nvidia ang maraming pagbabago at pagpapahusay, kabilang ang mga kakayahan sa pagpapakita, video encoding at decoding engine, pinahusay na asynchronous na pagpapatupad ng iba't ibang uri ng mga kalkulasyon sa GPU, gumawa ng mga pagbabago sa multi-chip rendering at nagpakilala ng bagong paraan ng pag-synchronize, Fast Sync.

Imposibleng hindi i-highlight ang Simultaneous Multi-Projection na teknolohiya, na tumutulong upang mapabuti ang pagganap sa mga virtual reality system, makakuha ng mas tamang pagpapakita ng mga eksena sa mga multi-monitor system, at magpakilala ng mga bagong diskarte sa pag-optimize ng pagganap. Ngunit ang mga VR application ay makakakuha ng pinakamalaking pagpapalakas sa bilis kapag sinusuportahan nila ang multi-projection na teknolohiya, na tumutulong upang makatipid ng mga mapagkukunan ng GPU ng kalahati kapag nagpoproseso ng geometric na data at ng isa at kalahating beses sa mga kalkulasyon ng per-pixel.

Sa mga purong pagbabago sa software, ang platform para sa paglikha ng mga screenshot sa mga laro na tinatawag na Ansel ay namumukod-tangi - ito ay magiging kawili-wiling subukan ito sa pagsasanay hindi lamang para sa mga naglalaro ng maraming, kundi pati na rin para sa mga interesado lamang sa mataas na kalidad na 3D graphics. Binibigyang-daan ka ng novelty na isulong ang sining ng paglikha at pag-retouch ng mga screenshot sa isang bagong antas. Well, tulad ng mga pakete para sa mga developer ng laro tulad ng GameWorks at VRWorks, Nvidia ay patuloy na nagpapabuti nang sunud-sunod - kaya, sa huli, isang kawili-wiling posibilidad ng mataas na kalidad na pagkalkula ng tunog ay lumitaw, na isinasaalang-alang ang maraming mga pagmuni-muni ng mga sound wave gamit ang hardware ray. pagsubaybay.

Sa pangkalahatan, sa anyo ng Nvidia GeForce GTX 1080 video card, isang tunay na pinuno ang pumasok sa merkado, na mayroong lahat ng kinakailangang katangian para dito: mataas na pagganap at malawak na pag-andar, pati na rin ang suporta para sa mga bagong tampok at algorithm. Ang mga unang mamimili ng video card na ito ay magagawang pahalagahan ang marami sa mga benepisyong binanggit kaagad, at ang iba pang mga posibilidad ng solusyon ay malalaman sa ibang pagkakataon, kapag mayroong malawak na suporta mula sa labas. software. Ang pangunahing bagay ay ang GeForce GTX 1080 ay naging napakabilis at mahusay, at, tulad ng inaasahan namin, ang mga inhinyero ng Nvidia ay pinamamahalaang ayusin ang ilan sa mga lugar ng problema (ang parehong mga asynchronous na kalkulasyon).

Graphics accelerator GeForce GTX 1070

| Parameter | Ibig sabihin |

|---|---|

| Pangalan ng chip code | GP104 |

| Produksiyong teknolohiya | 16nm FinFET |

| Bilang ng mga transistor | 7.2 bilyon |

| Core na lugar | 314 mm² |

| Arkitektura | Pinag-isa, na may hanay ng mga karaniwang processor para sa pagpoproseso ng stream ng maraming uri ng data: vertices, pixels, atbp. |

| Suporta sa DirectX hardware | DirectX 12, na may suporta para sa Feature Level 12_1 |

| Memory bus | 256-bit: walong independiyenteng 32-bit memory controllers na sumusuporta sa GDDR5 at GDDR5X memory |

| dalas ng GPU | 1506 (1683) MHz |

| Mga bloke sa pag-compute | 15 aktibo (sa 20 sa chip) streaming multiprocessors, kabilang ang 1920 (mula sa 2560) scalar ALU para sa mga kalkulasyon ng floating point sa loob ng balangkas ng IEEE 754-2008 standard; |

| Texturing block | 120 aktibo (mula sa 160 sa chip) texture addressing at filtering unit na may suporta para sa FP16 at FP32 na mga bahagi sa mga texture at suporta para sa trilinear at anisotropic na pag-filter para sa lahat ng mga format ng texture |

| Mga Raster Operations Unit (ROP) | 8 wide ROPs (64 pixels) na may suporta para sa iba't ibang anti-aliasing mode, kabilang ang programmable at may FP16 o FP32 frame buffer format. Ang mga bloke ay binubuo ng isang hanay ng mga nako-configure na ALU at responsable para sa depth generation at paghahambing, multisampling at blending |

| Suportahan ang suporta | Pinagsamang suporta para sa hanggang apat na monitor na konektado sa pamamagitan ng Dual Link DVI, HDMI 2.0b at DisplayPort 1.2 (1.3/1.4 Ready) |

| Mga Detalye ng GeForce GTX 1070 Reference Graphics | |

|---|---|

| Parameter | Ibig sabihin |

| Core dalas | 1506 (1683) MHz |

| Bilang ng mga unibersal na processor | 1920 |

| Bilang ng mga bloke ng texture | 120 |

| Bilang ng mga blending block | 64 |

| Epektibong dalas ng memorya | 8000 (4×2000) MHz |

| Uri ng memorya | GDDR5 |

| Memory bus | 256-bit |

| Laki ng memorya | 8 GB |